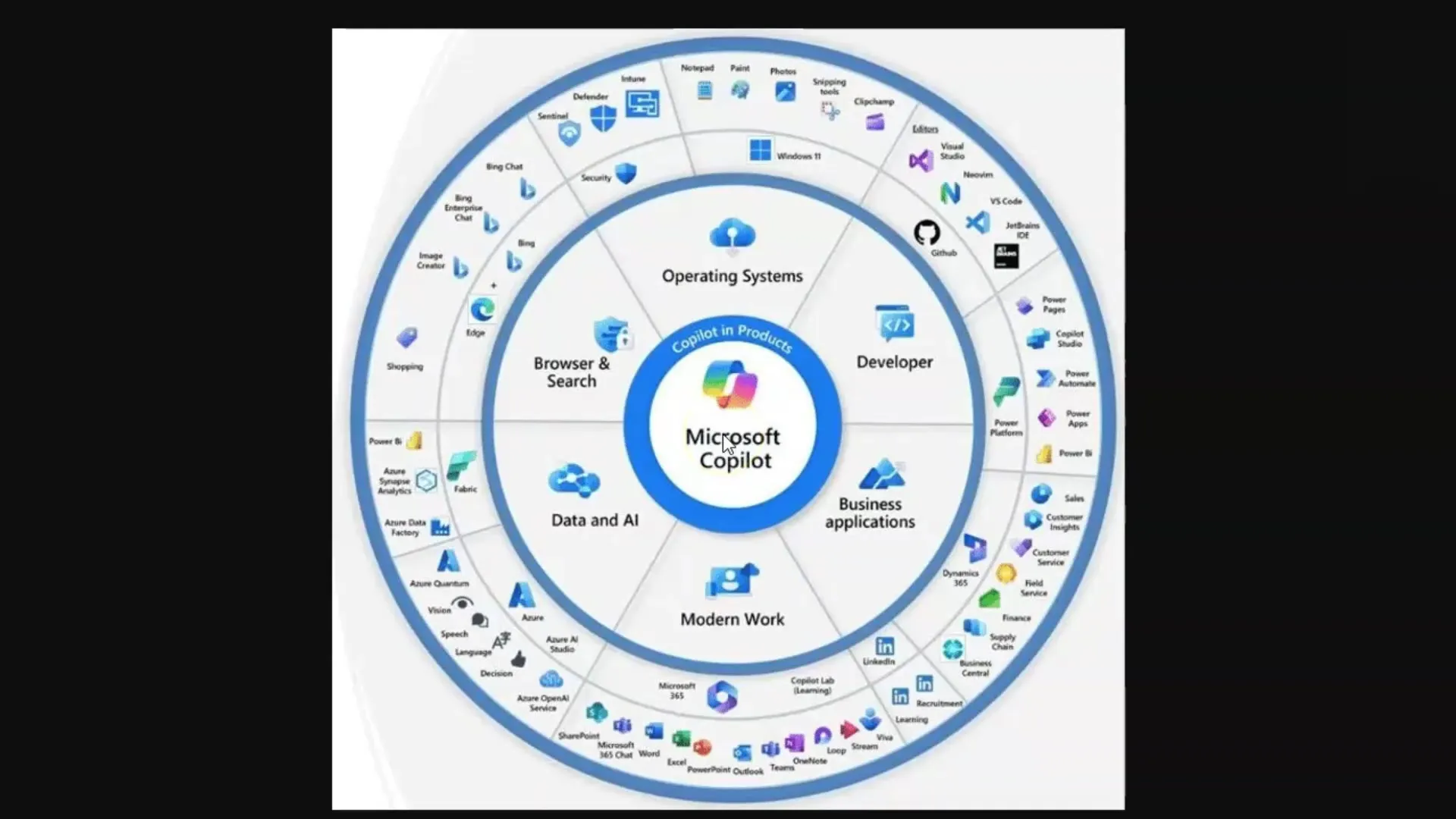

I denne vejledning vil du lære, hvordan Large Language Models (LLMs) og Diffusionsmodeller fungerer, især i forbindelse med Microsoft Copilot. Disse teknologier er afgørende for generering af tekster og billeder, der anvendes i forskellige kunstig intelligens-applikationer. For at udnytte disse værktøjer fuldt ud er det vigtigt at forstå de grundlæggende koncepter, der ligger bag dem.

Vigtigste erkendelser

- Large Language Models (LLMs) genererer tekster baseret på et stort korpus af trænede data.

- Diffusionsmodeller producerer billeder og lærer ved at behandle billede-tekst-par.

- Begrænsningerne ved token-limitationer er et centralt koncept i arbejdet med LLMs.

- Effektiv prompt engineering er vigtig for at opnå kvalitetsfulde svar fra LLMs.

Trin-for-trin-vejledning

Trin 1: Grundforståelse af Large Language Models (LLMs)

For at forstå LLMs skal du vide, at det er sprogmodeller, der er trænet på et enormt antal tekster. Disse modeller er i stand til at besvare spørgsmål ved at trække relevante oplysninger ud fra den lærte tekst. Husk på, at i denne sammenhæng er du computeren, der finder information.

Du stiller et spørgsmål, og modellen leder efter de relevante ord i dens "hukommelse", som består af de trænede data. Det er vigtigt, at du stiller de rigtige spørgsmål - et koncept kendt som "Prompt Engineering".

Trin 2: Token og deres betydning

Et LLM behandler tekst ved at opdele ord i "token", altså mindre enheder, der repræsenterer ord. For eksempel svarer et token i gennemsnit til cirka fire bogstaver eller tre fjerdedele af et ord. Disse token er vigtige, da hvert model kan behandle et bestemt antal token, hvilket kaldes en token-grænse.

Token-grænserne kan variere: Standardmodellen GPT-3.5 har f.eks. en grænse på 4.000 token, mens den aktuelle model GPT-4 arbejder med op til 128.000 token. Det er vigtigt at bemærke, at disse begrænsninger kan påvirke samtalen og evnen til at gemme og hente information.

Trin 3: Håndtering af token-limitationer

Da hvert sprogmodel har en token-grænse, er det afgørende at tage højde for dette, når du arbejder med LLMs. Hvis grænsen overskrides, kan modellen "glemme", hvad I har talt om. Det kan være nyttigt at oprette resumeer eller opdele store tekster i punktopstillinger for at få fat i de mest relevante oplysninger.

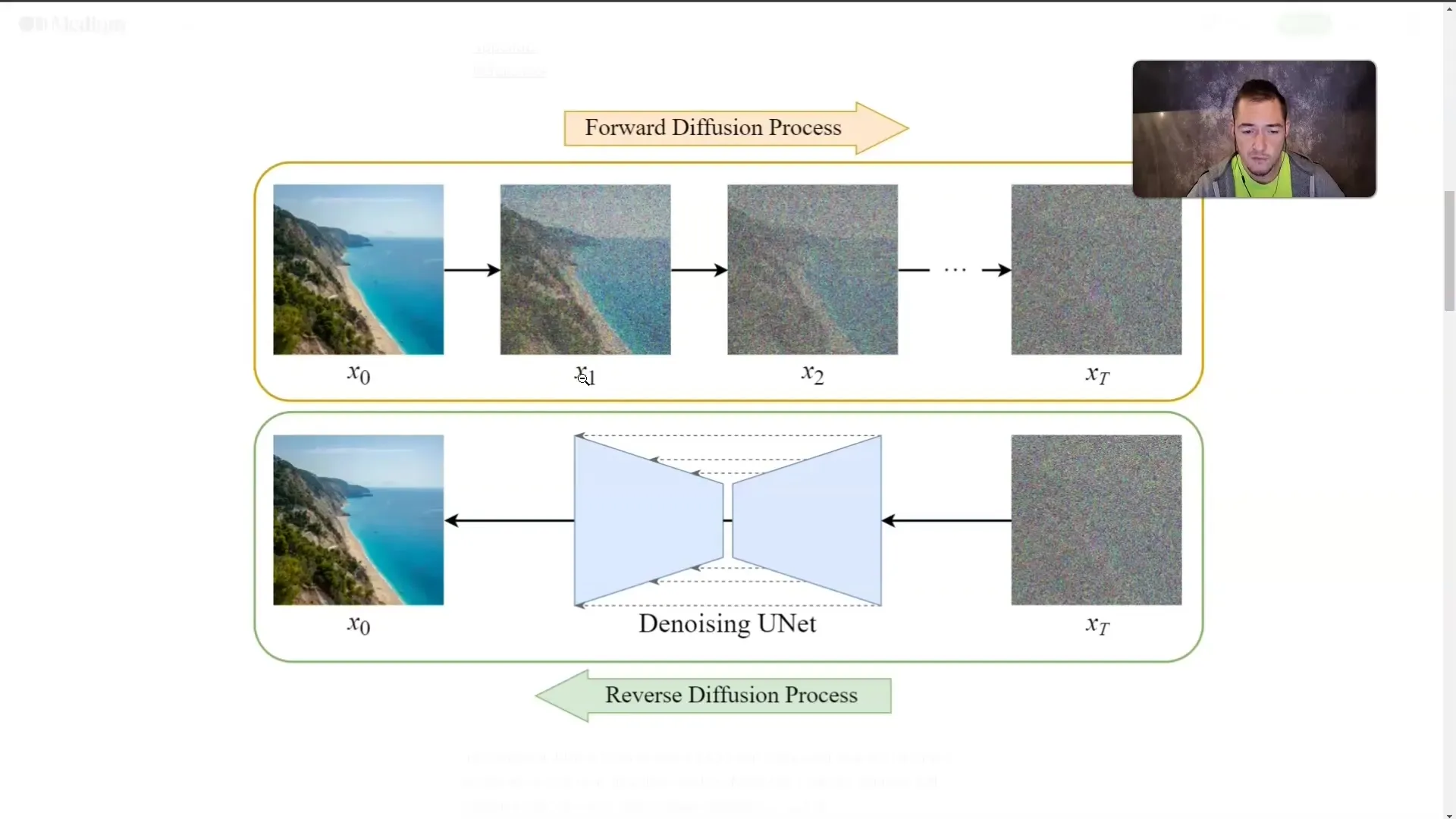

Trin 4: Forståelse af Diffusionsmodeller

Ud over LLMs er diffusionsmodeller også af stor betydning. Disse modeller genererer billeder ved at trænes med billede-tekst-par. Et billede overskygges gradvist med "tåge", indtil det ikke længere er synligt. Under træningen lærer modellen, hvordan billederne ser ud, selvom den ikke længere ser dem direkte.

Denne teknik tillader modellen at generere et billede ud fra en beskrivende tekst. Jo mere detaljeret du beskriver det ønskede indhold, desto mere præcist kan modellen generere billedet.

Trin 5: Anvendelse af koncepter

Når du har forstået, hvordan LLMs og diffusionsmodeller fungerer, er det vigtigt at anvende denne viden i praksis. Når du bruger Microsoft Copilot, skal du altid sørge for at stille præcise og relevante spørgsmål for at opnå de bedste resultater.

Uanset om du genererer tekster eller opretter billeder, vil kvaliteten af dine input direkte påvirke kvaliteten af resultaterne.

Opsamling

I denne vejledning har du lært de grundlæggende koncepter inden for LLMs og diffusionsmodeller. Du ved nu, hvordan disse teknologier fungerer, hvilken rolle token spiller, og hvor vigtigt Prompt Engineering er for kvaliteten af resultaterne. Forståelsen af disse koncepter er afgørende for at arbejde effektivt med Microsoft Copilot og lignende AI-applikationer.

Ofte stillede spørgsmål

Hvad er Large Language Models?LLMs er sprogmodeller, der er trænet på store tekstmængder for at generere tekster og besvare spørgsmål.

Hvad er Diffusionsmodeller?Diffusionsmodeller er AI-modeller, der genererer billeder ved at gradvist "tilsløre" dem og lære, hvad der gemmer sig bag tågerne.

Hvorfor er Tokens vigtige?Tokens er de mindste enheder af ord, som behandles af LLMs, og hver model har en grænse for, hvor mange tokens den kan behandle på én gang.

Hvordan kan jeg omgå Token-limet?Nogle metoder inkluderer at oprette resumeer eller opdele tekst i punktopstillinger.

Hvad er Prompt Engineering?Prompt Engineering refererer til kunsten at stille effektive og præcise spørgsmål for at opnå kvalitetsfulde svar fra LLMs.