Künstliche Intelligenz, insbesondere bei der Verwendung von Large Language Models (LLMs) wie Microsoft Copilot, ist das Verständnis von Prompt Engineering entscheidend. Ein gutes Verständnis der Aufforderung, die du an das Modell sendest, kann den Unterschied zwischen einem hilfreichen und einem unbrauchbaren Ergebnis ausmachen. In dieser Anleitung möchte ich dir einige wesentliche Techniken des Prompt Engineerings näherbringen, insbesondere die semantische Assoziation, strukturierte Prompts und Rollen. Diese Konzepte helfen dir, effektive Aufforderungen zu formulieren, die die Leistung von Microsoft Copilot maximieren. Lass uns ohne Umschweife eintauchen!

Wichtigste Erkenntnisse

- Prompt Engineering ist der Schlüssel zu effektiven Ergebnissen mit Microsoft Copilot.

- Semantische Assoziation ermöglicht es dem Modell, kontextuelle Zusammenhänge besser zu verstehen.

- Strukturierte Prompts helfen, spezifische Anforderungen klar zu kommunizieren.

- Rollen-Prompting gibt dem Modell spezifische Anweisungen, um den Kontext zu definieren und bessere Outputs zu liefern.

Schritt-für-Schritt-Anleitung

1. Das Verständnis von LLMs

Beginne mit dem grundlegenden Verständnis von large language models. Diese Modelle sind in der Lage, Texte zu erweitern oder zusammenzufassen. Du gibst entweder wenige Wörter vor und erhältst eine ausführliche Antwort, oder du gibst sehr detaillierte Informationen, und das Modell komprimiert diese. Das Wesentliche ist, dass sie aufgrund guter Prompts funktionieren.

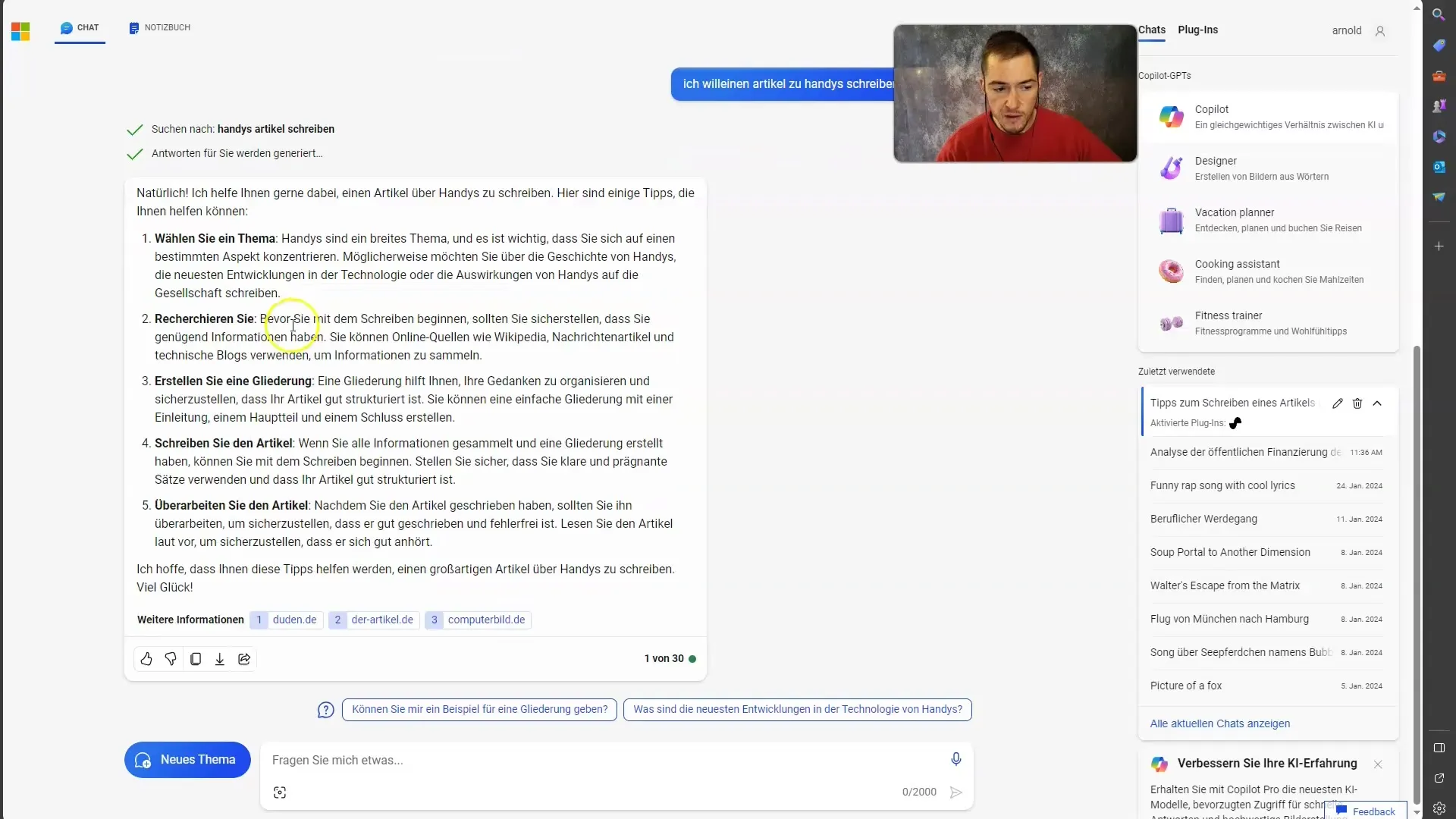

2. Beispiel eines schlechten Prompts

Um das Konzept besser zu verstehen, lass uns gemeinsam ein Beispiel für einen schlechten Prompt anschauen. Stell dir vor, du willst einen Artikel über Handys schreiben und formulierst das so: „Schreib mir einen Artikel über Handys“. Dieser Prompt gibt dem Modell so gut wie keinen Kontext, was die Antwort meist unbefriedigend macht.

3. Den Kontext erweitern

Ein effektiverer Ansatz ist, dem Modell mehr Kontext zu geben. Konzentriere dich auf einen spezifischen Aspekt von Handys, z.B. das „Google Pixel 8 Pro“. Indem du dich auf ein bestimmtes Thema fokussierst, erhöhst du die Wahrscheinlichkeit, dass das Modell wertvolle Informationen liefert.

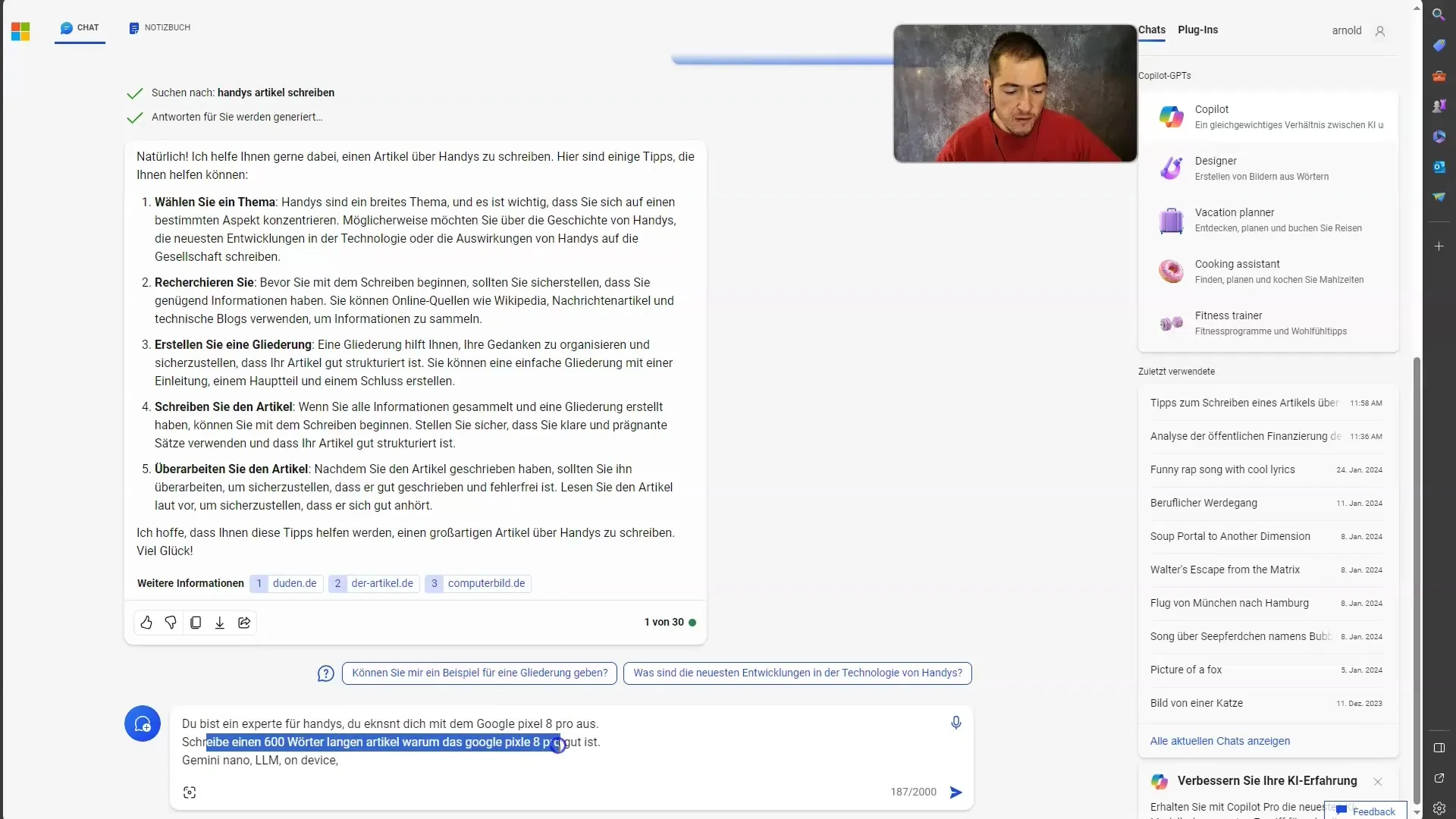

4. Verwendung von strukturierten Prompts

Strukturierte Prompts sind eine hervorragende Möglichkeit, deine Anforderungen klar zu kommunizieren. Beispielsweise könntest du sagen: „Du bist ein Experte für Handys. Schreibe einen 600 Wörter langen Artikel darüber, warum das Google Pixel 8 Pro gut ist.“ In dem Prompt wird deutlich, was du erwartest, und das Modell hat genügend Informationen, um eine umfassende Antwort zu generieren.

5. Rolle definieren mit Rollen-Prompting

Eine besonders nützliche Methode in deinem Prompt Engineering ist das Rollen-Prompting. Hierbei definierst du eine Rolle für das Modell, um die Perspektive zu verlängern. Wenn du sagst, dass das Modell „ein Experte für Handys“ ist, wird es spezifische Informationen herausfiltern und dir einen Output liefern, der auf diesem Expertenwissen basiert.

6. Integration von Schlüsselwörtern

Um deinem Prompt noch mehr Tiefe zu verleihen, kannst du Schlüsselwörter hinzufügen, die bei der Generierung des Outputs hilfreich sind. In unserem Beispiel könnte das Hinzufügen von Begriffen wie „Gemini Nano“ und „on-device“ dem Modell helfen, den Kontext zu erweitern und relevantere Inhalte zu finden.

7. Sicherstellen einer spezifischen Zielgruppe

Denke auch daran, für wen der Artikel gedacht ist. Ist es für Technikinteressierte, allgemeine Leser oder ein ganz bestimmtes Publikum? Das Modell kann seine Antwort entsprechend anpassen und den Schreibstil ändern. Dies kann auch in deinem prompt vermerkt werden, damit das Modell weiß, wie es die Informationen formulieren soll.

8. Feedback und Feinschliff

Nachdem du deinen Prompt formuliert hast und das Modell einen Artikel generiert hat, überprüfe das Ergebnis. Ist es das, was du dir gewünscht hast? Falls nicht, überarbeite deinen Prompt, füge mehr Kontext oder spezifische Anforderungen hinzu, und probiere es erneut. Der Prozess des Prompt Engineerings ist iterativ und erfordert manchmal mehrere Versuche.

Zusammenfassung

In dieser Anleitung hast du gelernt, wie wichtig das Prompt Engineering für den erfolgreichen Einsatz von Microsoft Copilot ist. Durch das Verständnis von semantischer Assoziation, strukturierten Prompts und Rollen-Prompting kannst du die Effizienz deiner Eingaben erheblich steigern. Achte darauf, deinem Modell den nötigen Kontext zu geben, um qualitativ hochwertige Ergebnisse zu erzielen. Experimentiere und feile an deinen Prompts, um das beste Output für deine Bedürfnisse zu erhalten!

Häufig gestellte Fragen

Was sind die grundlegenden Funktionen von großen Sprachmodellen?Große Sprachmodelle können Texte erweitern und zusammenfassen.

Warum ist der Kontext in einem Prompt wichtig?Ein klarer Kontext führt zu qualitativ hochwertigeren und relevanteren Outputs.

Was ist semantische Assoziation bei Prompt Engineering?Semantische Assoziation ermöglicht es dem Modell, assoziative Verbindungen zu verstehen und relevantere Inhalte zu liefern.

Wie kann ich strukturierte Prompts effektiv nutzen?Indem du spezifische Anforderungen und den gewünschten Output klar formulierst.

Was ist Rollen-Prompting?Rollen-Prompting definiert eine Rolle für das Modell, um den Kontext zu klären und bessere Antworten zu ermöglichen.