Large Language Models (LLM) wie Google Bard spielen eine bedeutende Rolle bei der Informationsvermittlung und der Unterstützung von Nutzern in verschiedenen Bereichen. Während diese Technologien beeindruckende Ergebnisse liefern, haben sie auch ihre Grenzen und Herausforderungen. In diesem Tutorial wirst du die Limitationen von Google Bard genauer betrachten. Ziel ist es, ein kritisches Verständnis für die Funktionsweise solcher Modelle zu entwickeln, damit du die bereitgestellten Informationen besser bewerten und gegebenenfalls hinterfragen kannst.

Wichtigste Erkenntnisse

- Google Bard und ähnliche Modelle sind nicht perfekt und haben Fehler.

- Die Outputs können inhaltlich falsch sein, obwohl sie überzeugend wirken.

- Du musst immer kritisch sein und Informationen überprüfen, bevor du sie verbreitest.

Schritt-für-Schritt-Anleitung

Verständnis der Fehlerquote

Es ist wichtig, dir bewusst zu machen, dass Google Bard, wie viele andere große Sprachmodelle, nicht fehlerfrei ist. Du hast wahrscheinlich schon festgestellt, dass die Qualität der Ausgaben variiert. Wenn du das Gefühl hast, dass die Ergebnisse nicht zufriedenstellend sind, dann erlaube dir, kritisch zu sein.

Fehlerhafte Outputs akzeptieren

Oft können die Ergebnisse von Google Bard nicht korrekt oder sogar völlig falsch sein. Dies bist du möglicherweise bereits bei deinen eigenen Erfahrungen in diesem Kurs begegnet. Es ist von großer Bedeutung, dass du verstehst, dass der Output von Bard nicht immer zuverlässig ist.

Verbreitung von Informationen hinterfragen

Wenn du Informationen hast, die von Google Bard stammen, solltest du diese vor der Verbreitung immer verifizieren. Du trägst Verantwortung dafür, dass die Informationen korrekt sind. Wenn du unsicher bist, ziehe zusätzliche Quellen zurate, bevor du etwas teilst.

Beispiele für Fehler analysieren

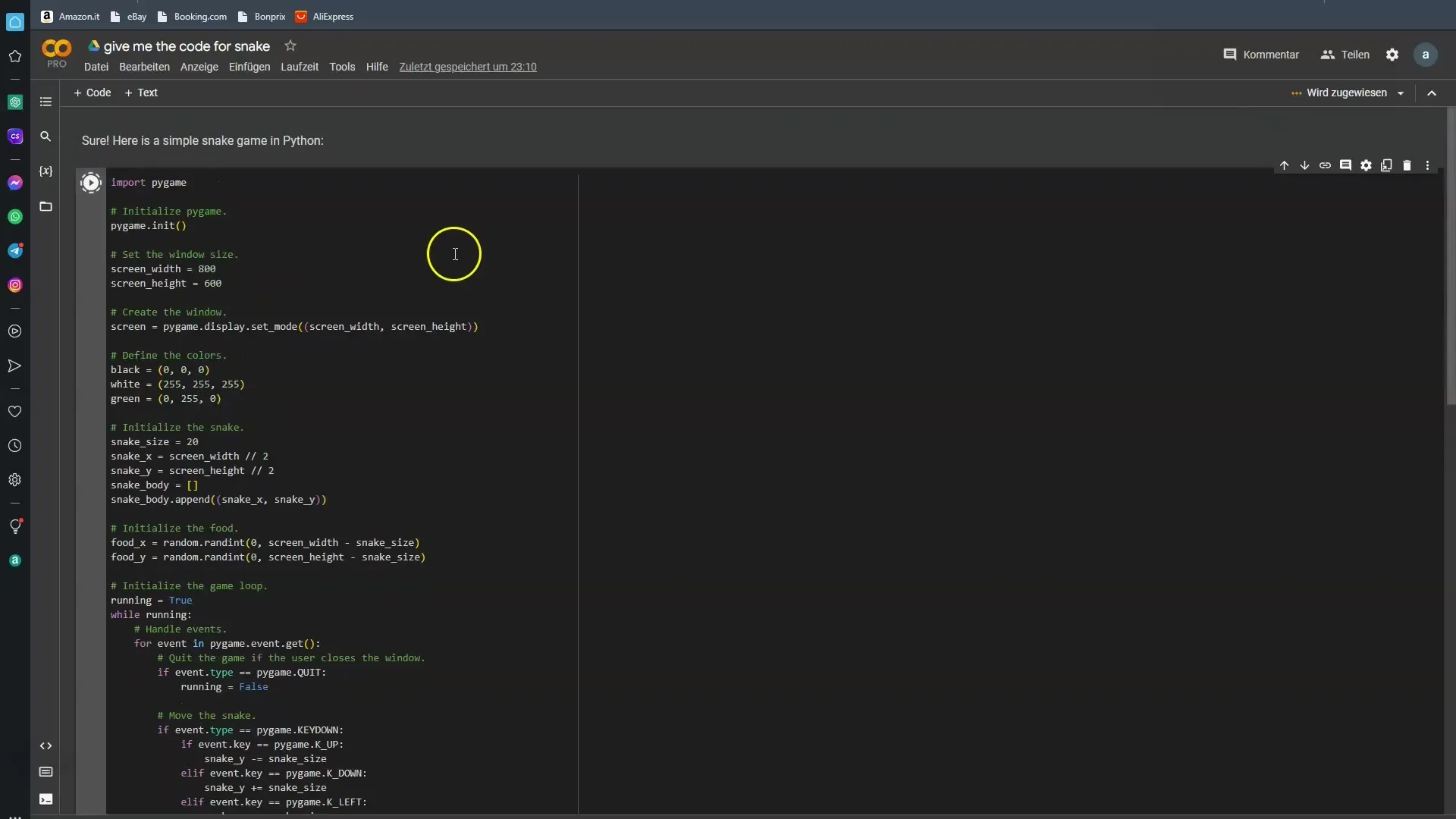

Um dir die Fehlerhaftigkeit von Google Bard vor Augen zu führen, ist es hilfreich, konkrete Beispiele anzuschauen. Ich habe Bard nach einem Programmcode für ein einfaches Snake-Spiel gefragt. In den meisten Fällen hat Bard dabei versagt. Lass uns sehen, ob wir diesmal mehr Glück haben.

Praktische Anwendung der Informationen

Gerade wenn du technische Fragen hast, solltest du dir bewusst sein, dass Antworten von Google Bard manchmal nicht deinen Erwartungen entsprechen. Es ist in Ordnung, es unter verschiedenen Bedingungen zu testen, um zu überprüfen, ob du die gewünschte Ausgabe erhältst.

Die Notwendigkeit des kritischen Denkens

Immer wenn du mit den Ergebnissen der KI arbeitest, ist es notwendig in den kritischen Denkmodus zu wechseln. Google Bard kann dir vieles präsentieren, aber nicht alles davon ist korrekt. Das Modell ist darauf trainiert, aus vielen Daten zu lernen, doch diese Daten sind nicht immer fehlerfrei.

Zukünftige Verbesserungen in Aussicht

Es ist zu erwarten, dass die Modelle in Zukunft weiter verbessert werden. Die Fehleranfälligkeit wird mit fortschreitender Technik hoffentlich abnehmen. Dennoch wollen wir auch die gegenwärtigen Einschränkungen anerkennen, sodass du diese bei der Nutzung berücksichtigen kannst.

Zusammenfassung

Die Welt der KI-gestützten Assistenz und Information ist aufregend und voller Möglichkeiten, birgt aber auch Risiken. Google Bard und ähnliche Modelle sind ein Schritt in die Zukunft, bringen jedoch Einschränkungen mit sich. Es ist entscheidend, dass du diese Limitierungen erkennst und lernst, die Informationen mit einer kritischen Perspektive zu betrachten.

Häufig gestellte Fragen

Was sind die Hauptfehler von Google Bard?Die Hauptfehler von Google Bard liegen in der Ungenauigkeit der bereitgestellten Informationen.

Warum sollte ich die von Bard bereitgestellten Informationen überprüfen?Die von Bard bereitgestellten Informationen können fehlerhaft sein und sind nicht immer zuverlässig.

Kann ich Google Bard für technische Fragen nutzen?Ja, jedoch solltest du die Antworten kritisch hinterfragen und gegebenenfalls andere Quellen zurate ziehen.

Wer hat Google Bard trainiert?Google Bard und ähnliche Modelle werden von Menschen trainiert, was zu menschlichen Fehlern führen kann.

Wird Google Bard in Zukunft besser werden?Ja, es wird erwartet, dass zukünftige Versionen weniger fehleranfällig sind.