Los Grandes Modelos de Lenguaje (LLM) como Google Bard juegan un papel importante en la transmisión de información y el apoyo a los usuarios en diferentes áreas. Aunque estas tecnologías ofrecen resultados impresionantes, también tienen sus límites y desafíos. En este Tutorial vas a examinar más de cerca las limitaciones de Google Bard. El objetivo es desarrollar una comprensión crítica sobre el funcionamiento de tales modelos para que puedas evaluar mejor la información proporcionada y cuestionarla si es necesario.

Principales Conclusiones

- Google Bard y modelos similares no son perfectos y tienen errores.

- Las salidas pueden ser incorrectas en contenido, aunque sean convincentes.

- Siempre debes ser crítico y verificar la información antes de compartirla.

Instrucciones Paso a Paso

Comprender la Tasa de Error

Es importante tener en cuenta que Google Bard, al igual que muchos otros grandes modelos de lenguaje, no es infalible. Probablemente hayas notado que la calidad de las salidas varía. Si sientes que los resultados no son satisfactorios, permítete ser crítico.

Aceptar Salidas Erróneas

A menudo, los resultados de Google Bard pueden ser incorrectos o incluso totalmente equivocados. Esto es algo con lo que probablemente ya te has encontrado en tus propias experiencias en este curso. Es crucial que entiendas que la salida de Bard no siempre es fiable.

Cuestionar la Difusión de Información

Si tienes información proveniente de Google Bard, siempre debes verificarla antes de difundirla. Tienes la responsabilidad de que la información sea correcta. Si tienes dudas, consulta fuentes adicionales antes de compartir algo.

Análisis de Ejemplos de Errores

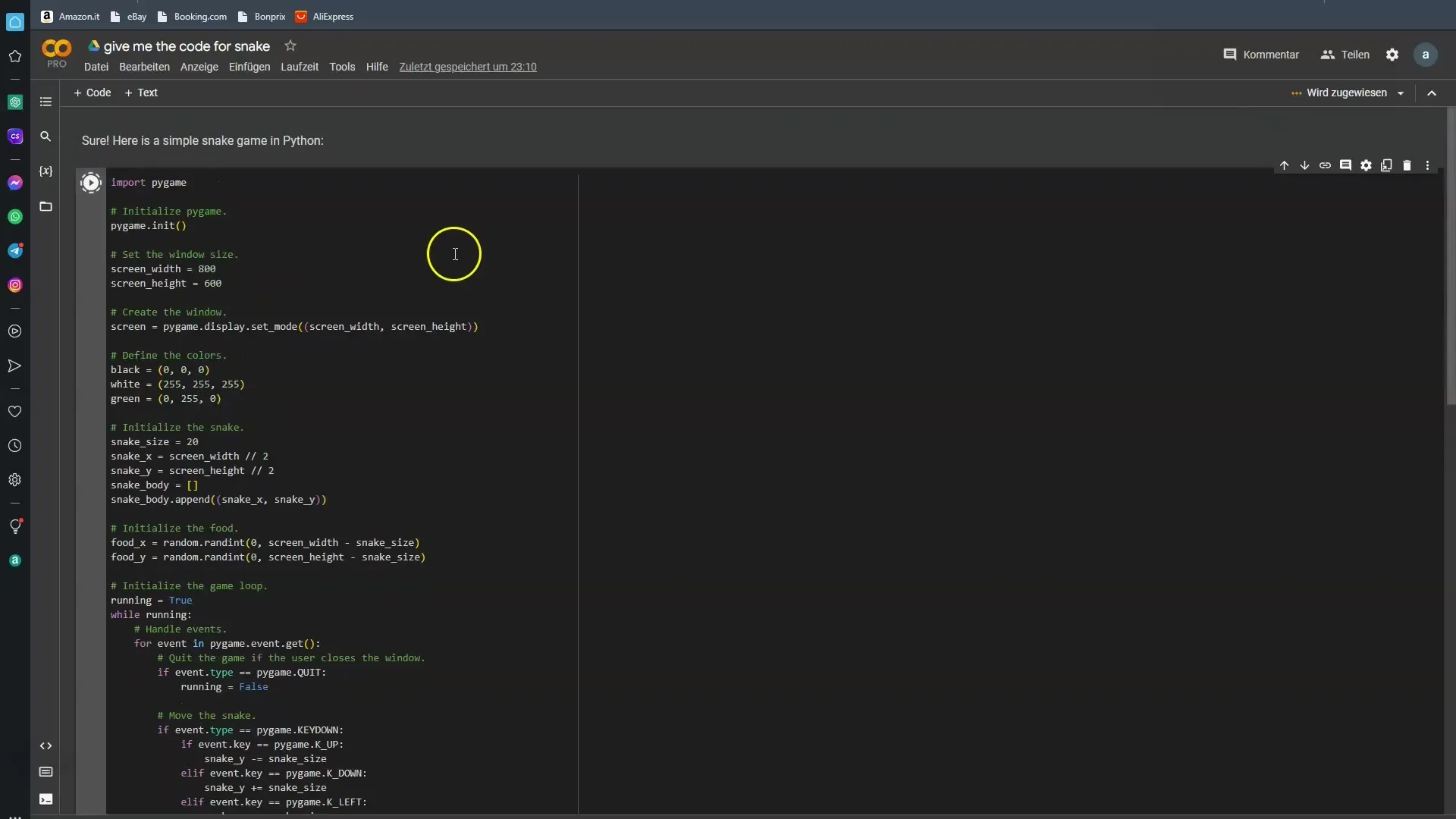

Para entender la errónea de Google Bard, es útil examinar ejemplos concretos. Le pedí a Bard código de programa para un juego de la Serpiente simple. En la mayoría de los casos, Bard falló en ello. Veamos si tenemos más suerte esta vez.

Aplicación Práctica de la Información

Especialmente cuando tengas preguntas técnicas, debes ser consciente de que las respuestas de Google Bard a veces no cumplen tus expectativas. Está bien probar bajo diferentes condiciones para comprobar si obtienes la salida deseada.

La Necesidad del Pensamiento Crítico

Cada vez que trabajes con los resultados de la IA, es necesario activar el modo de pensamiento crítico. Google Bard puede presentarte muchas cosas, pero no todas son correctas. El modelo está entrenado para aprender de muchos datos, pero estos datos no son siempre libres de errores.

Mejoras Futuras en Perspectiva

Se espera que en el futuro los modelos sean mejorados continuamente. Con el avance de la tecnología, la propensión a errores debería disminuir. Aun así, también debemos reconocer las limitaciones actuales para que las tengas en cuenta al usarlos.

Resumen

El mundo de la asistencia y la información impulsada por IA es emocionante y lleno de oportunidades, pero también conlleva riesgos. Google Bard y modelos similares representan un avance hacia el futuro, pero también presentan limitaciones. Es crucial que reconozcas estas limitaciones y aprendas a mirar la información con una perspectiva crítica.

Preguntas Frecuentes

¿Cuáles son los principales errores de Google Bard?Los principales errores de Google Bard radican en la inexactitud de la información proporcionada.

¿Por qué debería verificar la información proporcionada por Bard?La información proporcionada por Bard puede ser incorrecta y no siempre fiable.

¿Puedo usar Google Bard para preguntas técnicas?Sí, pero debes cuestionar críticamente las respuestas y, si es necesario, consultar otras fuentes.

¿Quién entrenó a Google Bard?Google Bard y modelos similares son entrenados por humanos, lo que puede llevar a errores humanos.

¿Mejorará Google Bard en el futuro?Sí, se espera que las futuras versiones sean menos propensas a errores.