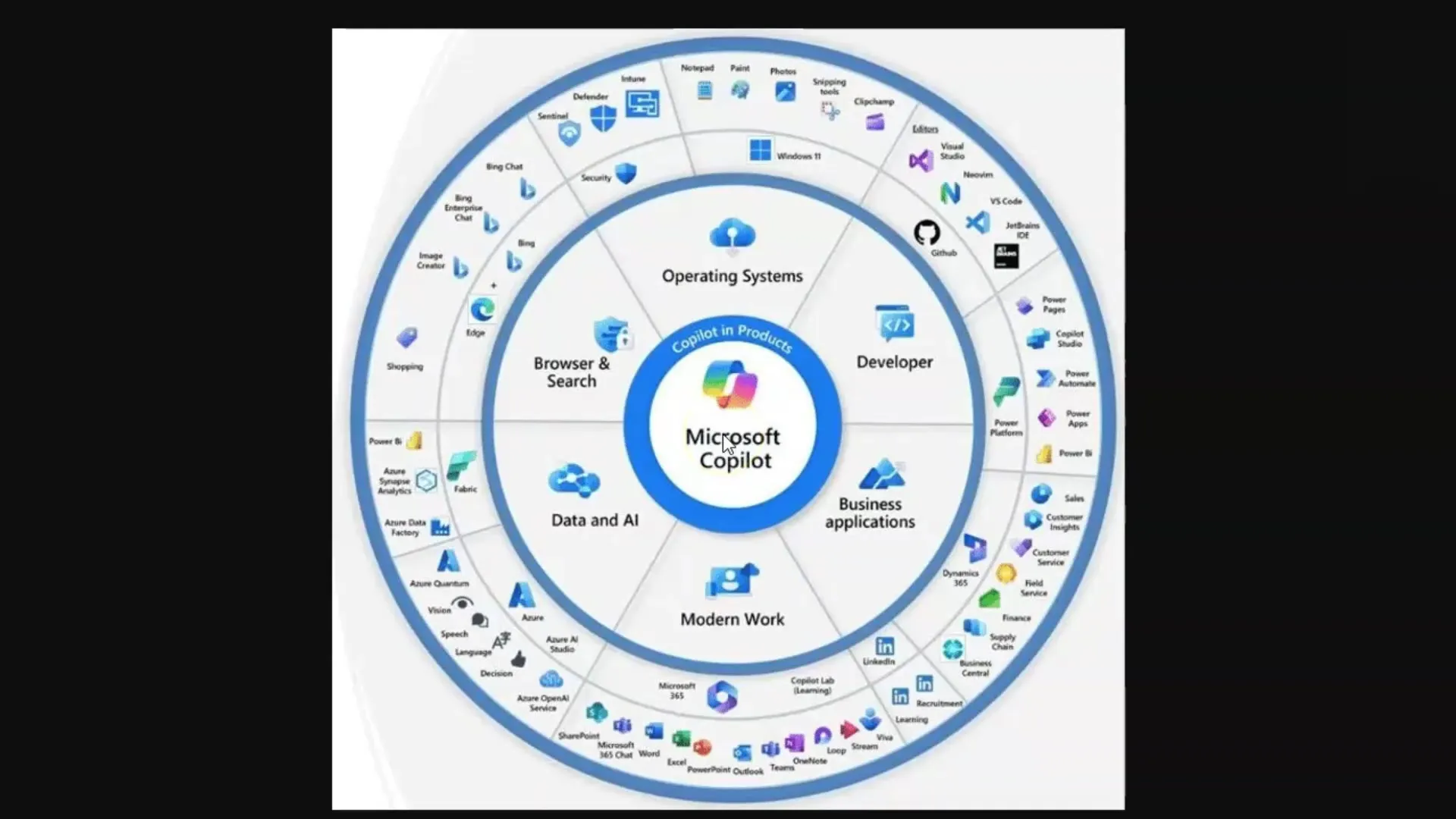

In questo tutorial imparerai come funzionano i Large Language Models (LLM) e i modelli di Diffusione, in particolare in relazione a Microsoft Copilot. Queste tecnologie sono cruciali per la generazione di testi e immagini utilizzati in varie applicazioni di intelligenza artificiale. Per sfruttare appieno il potenziale di questi strumenti, è importante comprendere i concetti di base che stanno dietro di essi.

Concetti Chiave

- I Large Language Models (LLM) generano testi basati su un vasto corpus di dati di allenamento.

- I modelli di Diffusione generano immagini e imparano attraverso l'elaborazione di coppie immagine-testo.

- Il limite di token è un concetto chiave nel lavoro con i LLM.

- L'ingegneria del prompt efficace è importante per ottenere risposte di qualità dai LLM.

Guida Passo a Passo

Passo 1: Comprendere i Large Language Models (LLM)

Per comprendere i LLM, devi sapere che sono modelli linguistici addestrati su una vasta quantità di testi. Questi modelli sono capaci di rispondere alle domande estrarre informazioni rilevanti dal testo appreso. Ricorda che in questo contesto sei il computer che trova le informazioni.

Fai una domanda e il modello cerca le parole corrispondenti nella sua "memoria", costituita dai dati di allenamento. È importante formulare le domande correttamente, un concetto noto come "Prompt Engineering".

Passo 2: Token e il Loro Significato

Un LLM elabora il testo suddividendo le parole in "Token", cioè unità più piccole che rappresentano le parole. Ad esempio, un Token corrisponde in media a circa quattro lettere o tre quarti di parola. Questi Token sono importanti perché ogni modello può elaborare un determinato numero di Token contemporaneamente, in quello che è noto come limite di Token.

I limiti dei Token possono variare: ad esempio, il modello standard GPT-3.5 ha un limite di 4.000 Token, mentre il modello attuale GPT-4 può lavorare con fino a 128.000 Token. È importante notare che queste limitazioni possono influenzare la conversazione e la capacità di memorizzare e recuperare informazioni.

Passo 3: Gestire le Limitazioni dei Token

Dato che ogni modello linguistico ha un limite di Token, è cruciale tenerne conto quando si lavora con i LLM. Se il limite viene superato, il modello potrebbe "dimenticare" di cosa stavate parlando. In questo contesto, può essere utile creare riepiloghi o suddividere grandi testi in punti per catturare le informazioni più rilevanti.

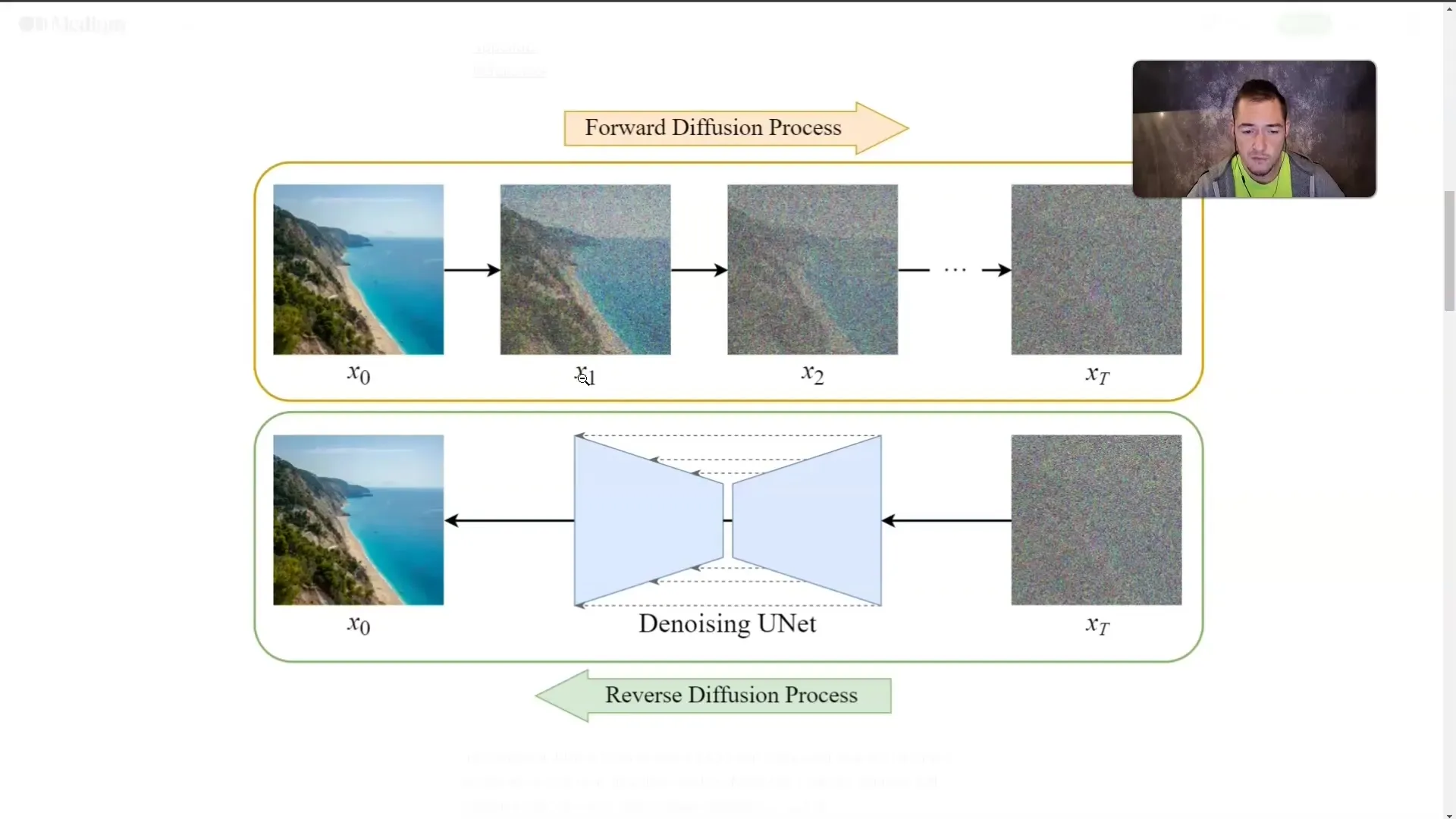

Passo 4: Comprendere i Diffusion Models

Oltre ai LLM, i modelli di diffusione sono di grande importanza. Questi modelli generano immagini addestrandosi con coppie immagine-testo. Durante l'addestramento, un'immagine viene gradualmente sovrapposta da "nebbia" fino a non essere più visibile. Durante questo processo, il modello impara come appaiono le immagini, anche se non le vede direttamente.

Questa tecnica consente al modello di generare un'immagine da un testo descrittivo. Più dettagliatamente descrivi il contenuto desiderato, più precisamente il modello sarà in grado di generare l'immagine.

Passo 5: Applicazione dei Concetti

Dopo aver compreso il funzionamento dei LLM e dei modelli di diffusione, è importante applicare praticamente queste conoscenze. Nell'uso di Microsoft Copilot, assicurati sempre di fare domande precise e rilevanti per ottenere i migliori risultati.

Sia che stai generando testi o creando immagini, la qualità dei tuoi input influenzerà direttamente la qualità degli output.

Sommario

In questo tutorial hai imparato i concetti di base dei LLM e dei modelli di diffusione. Ora sai come funzionano queste tecnologie, il ruolo dei Token e l'importanza dell'Ingegneria del Prompt per la qualità dei risultati. Comprendere questi concetti è fondamentale per lavorare efficacemente con Microsoft Copilot e applicazioni simili di intelligenza artificiale.

Domande Frequenti

Cos'è un Large Language Model?I LLM sono modelli linguistici addestrati su ampie quantità di testo per generare testi e rispondere a domande.

Cos'è un Diffusion Model?I diffusori sono modelli di intelligenza artificiale che generano immagini sovrapponendo gradatamente "nebbia" e imparando cosa si nasconde dietro la nebbia.

Perché sono importanti i Token?I Token sono le unità più piccole delle parole elaborate dai LLM, e ogni modello ha un limite su quanti Token può elaborare contemporaneamente.

Come posso superare il limite dei Token?Alcuni metodi includono la creazione di riepiloghi o la suddivisione di testi in punti.

Cos'è l'Ingegneria del Prompt?L'Ingegneria del Prompt si riferisce all'arte di fare domande efficaci e precise per ottenere risposte di qualità da parte dei LLM.