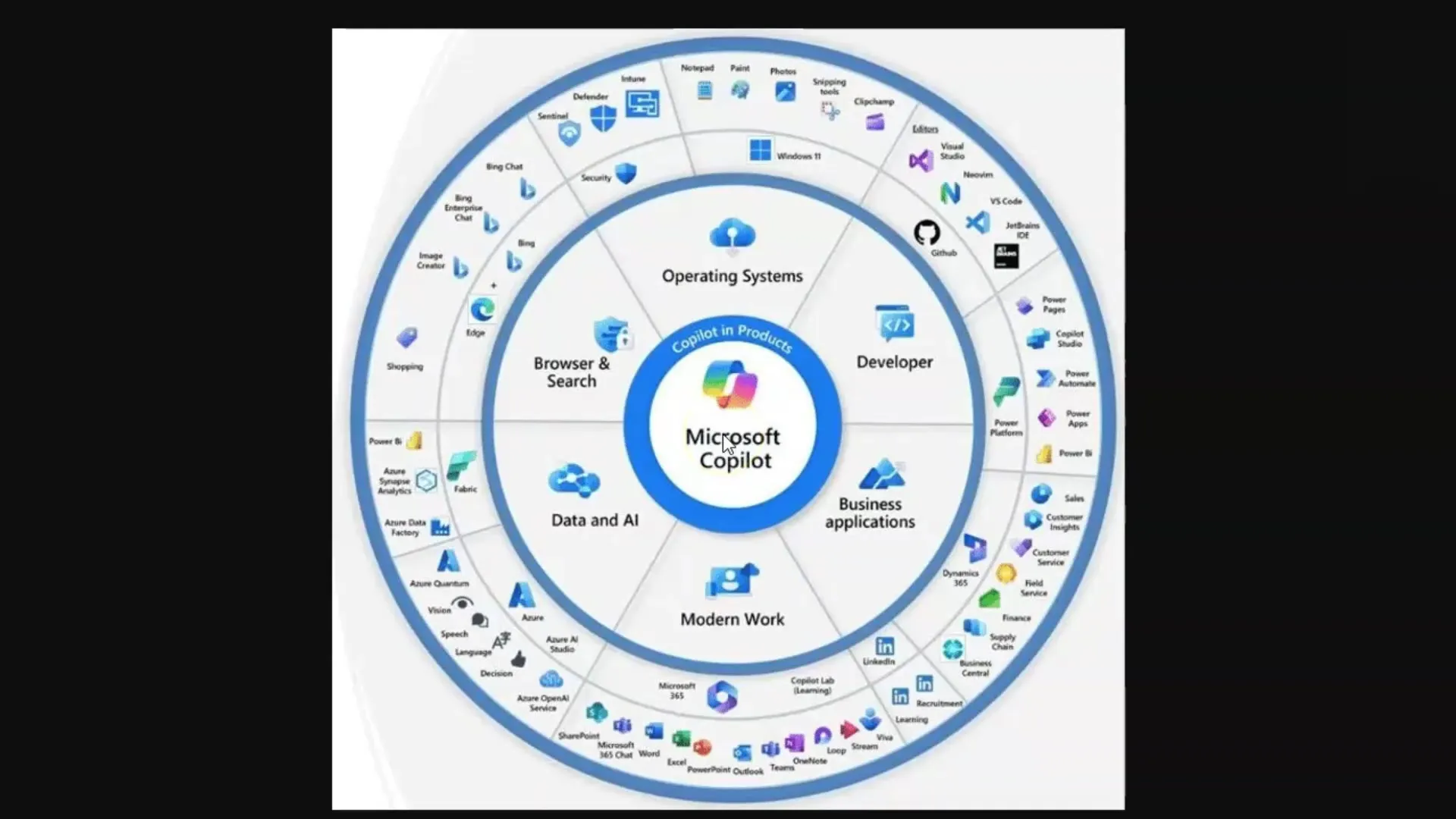

このチュートリアルでは、Large Language Models(LLMs)とDiffusionsmodelleの動作について学びます。特に、Microsoft Copilotと関連しています。これらの技術は、様々な人工知能アプリケーションで使用されるテキストや画像の生成に不可欠です。これらのツールのフルポテンシャルを引き出すには、それらの背後にある基本的な概念を理解することが重要です。

重要な洞察

- Large Language Models (LLMs)は、トレーニングされたデータの大規模なコーパスに基づいてテキストを生成します。

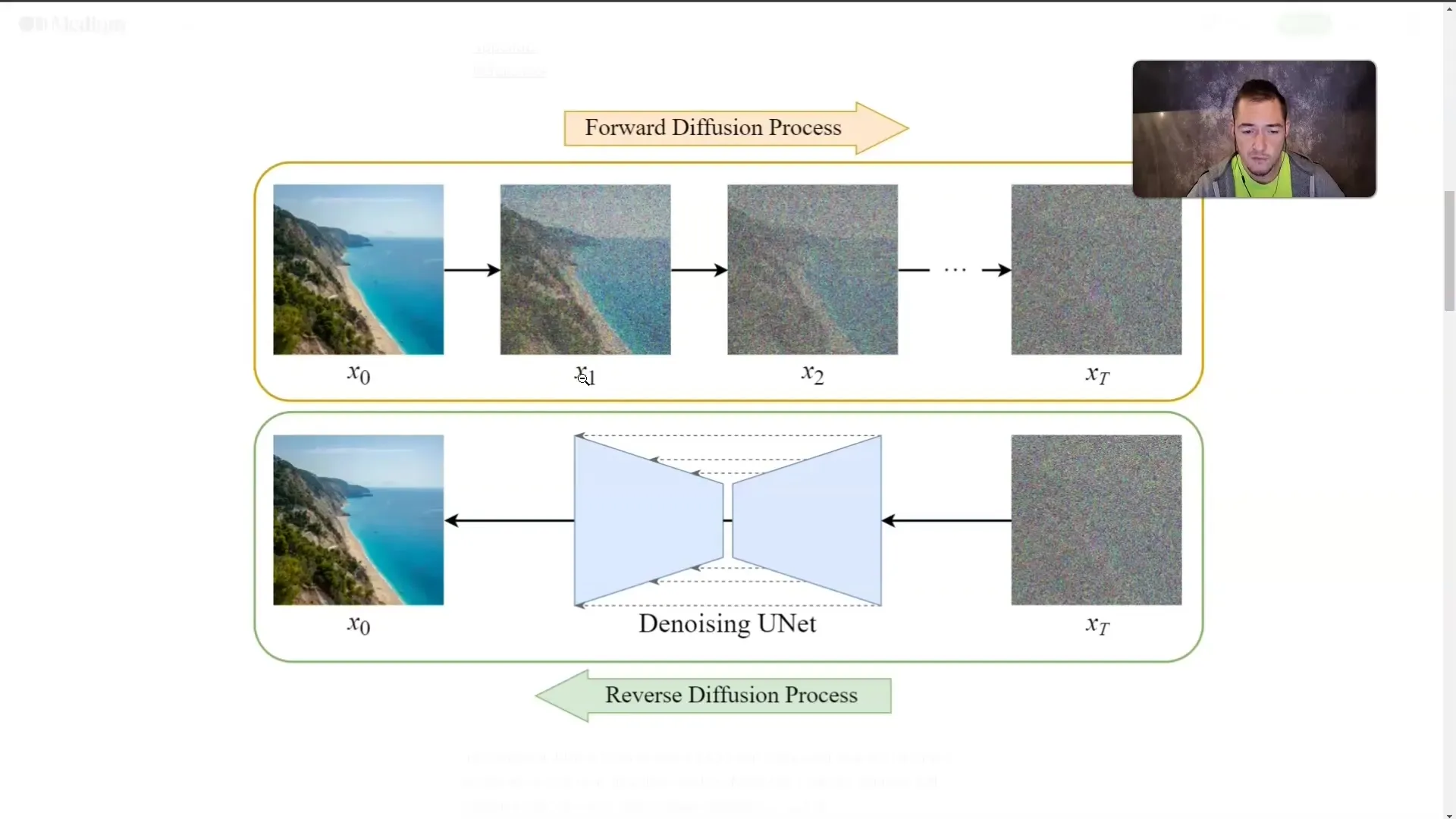

- Diffusionsmodelleは、画像を生成し、画像テキストペアの処理を通じて学習します。

- LLMsとの作業において中心的な概念であるトークン制限による制約

- 質の高いLLMの回答を得るためには、効果的なプロンプトエンジニアリングが重要です。

ステップバイステップガイド

ステップ 1: Large Language Models(LLMs)の基本理解

LLMsを理解するには、トレーニングされたテキストの膨大な量に基づいてトレーニングされた言語モデルであることを知る必要があります。これらのモデルは、学習したテキストから関連情報を抽出することで質問に答えることができます。この文脈では、情報を探し出すコンピュータであると考えてください。

質問を投げかけ、モデルがトレーニングデータからの関連する情報を抽出して質問に答えることが重要です。この文脈では、「プロンプトエンジニアリング」として知られるコンセプトが重要です。

ステップ 2: トークンとその意味

LLMは、単語を「トークン」、つまり単語を表すより小さな単位に分解してテキストを処理します。例えば、平均して、1つのトークンは約4文字または四分の三の単語に相当します。これらのトークンは、それぞれのモデルが同時に処理できるトークン数、すなわちトークンの制限と呼ばれるものが重要です。

トークンの制限は変動する場合があります。たとえば、標準モデルGPT-3.5は4,000トークンの制限を持っていますが、最新モデルのGPT-4は最大128,000トークンまで動作します。これらの制限は、会話や情報の保存と取得の能力に影響を及ぼすことを考慮することが重要です。

ステップ 3: トークン制限の扱い方

各言語モデルにはトークン制限があるため、LLMsを操作する際にはこれを考慮することが非常に重要です。制限を超えると、モデルは話していた内容を「忘れる」可能性があります。この場合、要約を作成したり、大きなテキストをポイントに分割することで、最も関連性の高い情報を把握することが役立ちます。

ステップ 4: Diffusionsmodelleの理解

LLMsに加えて、Diffusionsmodelleも重要です。これらのモデルは、画像テキストペアを用いて画像を生成します。画像は段階的に「霧」で覆われ、視認できなくなるまで繰り返されます。トレーニング中、モデルは画像が直接見えなくても、その見た目を学習します。

この技術により、モデルは記述テキストから画像を生成できます。望ましい内容をより詳細に記述すれば、モデルがより正確に画像を生成できます。

ステップ 5: 概念の適用

LLMsとDiffusionsmodelleの動作原理を理解したら、これらの知識を実践に活かすことが重要です。Microsoft Copilotを使用する際には、最良の結果を得るために正確で関連性の高い質問を投げかけることが重要です。

テキストの生成や画像の作成に関わらず、入力の品質が出力の品質に直結します。

まとめ

このチュートリアルでは、LLMsとDiffusionsmodelleの基本的な概念を学びました。これらの技術の動作方法、トークンの役割、そして品質の向上においてプロンプトエンジニアリングの重要性を理解しました。これらの概念を理解することは、Microsoft Copilotや類似のAIアプリケーションと効果的に作業するために不可欠です。

よくある質問

Large Language Modelsとは何ですか?LLMsは、テキストを生成し質問に答えるために大規模なテキストデータでトレーニングされた言語モデルです。

Diffusionsmodelleとは何ですか?Diffusionsmodelleは、画像を生成するために画像テキストペアでトレーニングされるAIモデルです。画像を「霧」で隠しながら、霧の背後に何が隠れているかを学習します。

なぜトークンは重要ですか?トークンはLLMsによって処理される単語の最小単位であり、各モデルが同時に処理できるトークンの量には制限があります。

トークン制限を回避する方法は?要約を作成したり、テキストをポイントに分割するなどの方法があります。

プロンプトエンジニアリングとは何ですか?プロンプトエンジニアリングとは、質の高いLLMの回答を得るために効果的で正確な質問を投げかける技術です。