言語モデル(LLM) 、Google Bard のようなものは、情報提供やさまざまな分野でのユーザーサポートに重要な役割を果たしています。 これらの技術は印象的な結果をもたらす一方で、限界や課題もあります。 このチュートリアル では、Google Bard の 制限 について詳しく見ていきます。 こうすることで、そのようなモデルの動作原理に対する批判的な理解を深め、提供される情報をよりよく評価し、必要に応じて疑問を投げかけることができるようになります。

主な知見

- Google Bardや同様のモデルは完璧ではなく、誤りを含むことがあります。

- 出力は説得力がある場合でも内容的に誤っていることがあります。

- 情報を広く伝える前に、いつも批判的に検証してください。

ステップバイステップガイド

誤差率の理解

Google Bardなどの大規模言語モデルは完璧でないことを認識することが重要です。 出力の品質にばらつきがあることに気づいたかもしれません。 結果が満足できないと感じる場合は、批判的になることを許されています。

誤った出力を受け入れる

Google Bardの結果は正しくない可能性があり、時には完全に間違っていることがあります。 これをこのコースで何かしらの経験したことがあるかもしれません。 Bardの出力が常に信頼できるわけではないことを理解することが非常に重要です。

情報の普及を疑う

Google Bardからの情報を共有する前には常に確認してください。 情報が正確であることを確認する責任があります。 不確かな場合は、情報を共有する前に追加の情報源を参照してください。

エラーの例を分析する

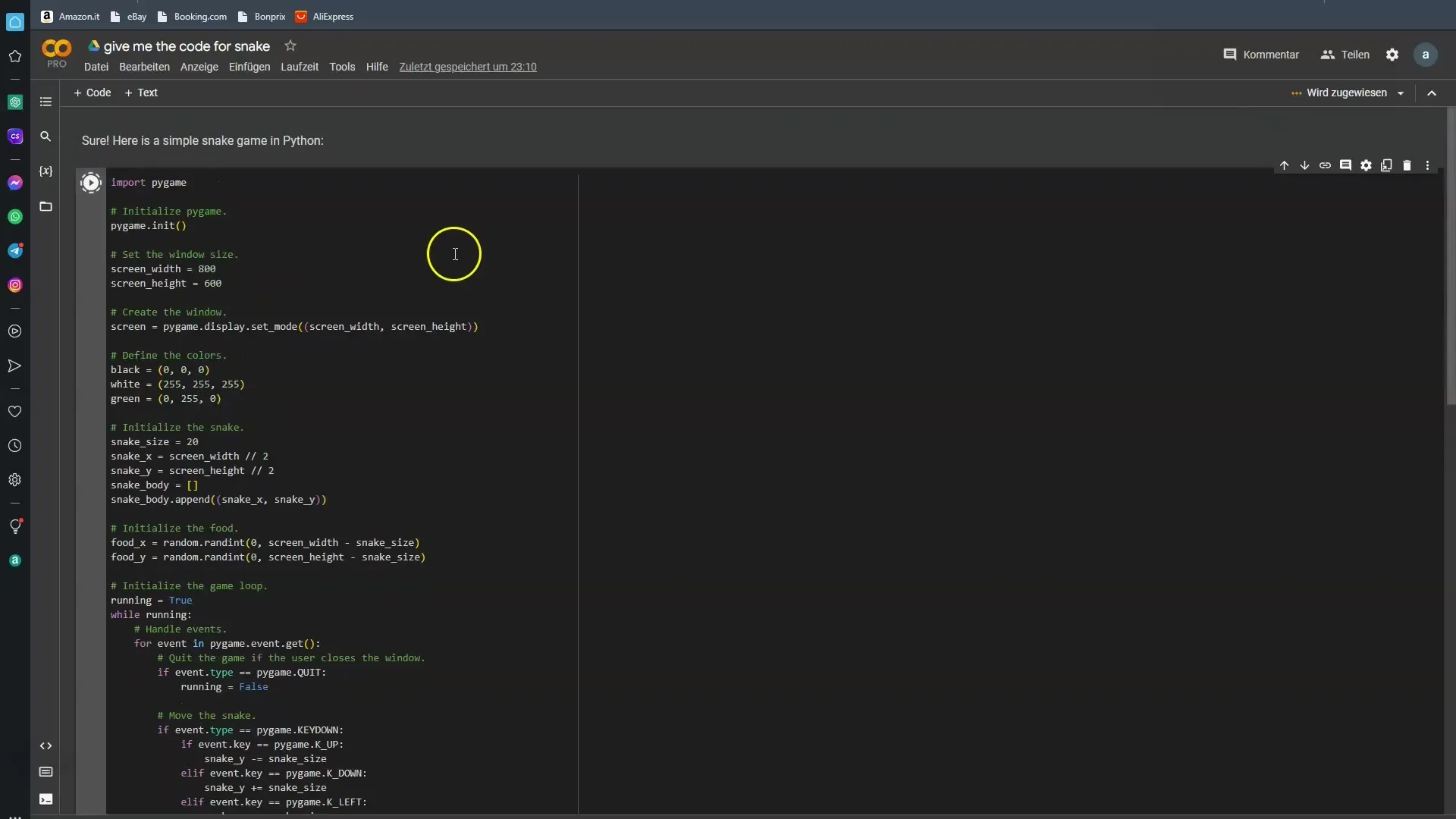

Google Bardの誤りを理解するために、具体的な例を見ることが役立ちます。 私は簡単なスネークゲームのプログラムコードをBardに尋ねました。 大抵の場合、Bardは失敗しました。 今回はもう少し幸運を試してみましょう。

情報の実用的な適用

技術的な質問がある場合は、Google Bardの回答が期待通りでない可能性があることを認識することが重要です。 望む結果を得られるか確認するために、さまざまな条件でテストすることも構いません。

批判的思考の必要性

AIの結果を扱う際は常に批判的思考に移行する必要があります。 Google Bardは多くのデータから学習するよう訓練されていますが、これらのデータが常に正確であるわけではないことを理解する必要があります。

将来の改善が見込まれる

将来、モデルがさらに改善されることが期待されています。 技術が進歩すれば、誤差の可能性が減少することを望んでいます。 ただし、現在の制約も認識し、利用する際に考慮することが重要です。

まとめ

AI支援の情報の世界は刺激的で多くの可能性を秘めていますが、リスクも抱えています。 Google Bardや同様のモデルは未来に向けた一歩ですが、それには制限もあります。 これらの制約を認識し、情報を批判的な視点で見ることを学ぶことが重要です。

よくある質問

Google Bardの主なエラーは何ですか?Google Bardの主なエラーは提供される情報の不正確さにあります。

Bardから提供された情報を確認すべき理由は?Bardから提供された情報には誤りが含まれる可能性があり、常に信頼できるとは限りません。

技術的な質問にGoogle Bardを利用できますか?はい、ただし回答には批判的に問い合わせ、必要に応じて他の情報源を参照する必要があります。

Google Bardは誰によって訓練されたのですか?Google Bardや同様のモデルは人間によって訓練され、それには人為的なエラーが含まれる可能性があります。

Google Bardは将来改善される見込みですか?はい、将来のバージョンはより誤りが少なくなることが期待されています。