공대 언어 모델(LLM)인 Google Bard 은 다양한 분야에서 사용자 지원 및 정보 전달에서 중요한 역할을 합니다. 이러한 기술들은 탁월한 결과를 보여주지만, 그들의 한계와 도전 과제도 가지고 있습니다. 이 튜토리얼에서는 Google Bard의 한계를 자세히 살펴보게 됩니다. 이를 통해 해당 모델들의 작동 방식에 대한 비평적 이해를 개발하여 제공된 정보를 더 잘 평가하고 필요시 의문을 제기할 수 있도록 합니다.

주요 인사이트

- Google Bard 및 유사 모델은 완벽하지 않고 오류가 있을 수 있습니다.

- 결과물은 그들의 설득력에도 불구하고 내용적으로 오답일 수 있습니다.

- 정보를 전파하기 전에 항상 비판적으로 검토하고 확인해야 합니다.

단계별 안내

오류율 이해

Google Bard와 같은 대규모 언어 모델이 완벽하지 않다는 것을 인식하는 것이 중요합니다. 결과물의 품질이 다양하게 나타날 수 있음을 이미 알아차린 적이 있을 것입니다. 결과물이 만족스럽지 않다고 느낄 때, 비판적으로 접근하는 것을 허용하세요.

오류 있는 결과물 수용

Google Bard의 결과물은 종종 부정확하거나 완전히 잘못될 수 있습니다. 이러한 경우에 이미 이 과정에서 직면한 경험을 통해 알 수 있습니다. Bard의 결과물이 항상 신뢰할 만한 것은 아님을 이해하는 것이 중요합니다.

정보 전파 의문제기

Google Bard에서 비롯된 정보를 가지고 있다면, 해당 정보를 전파하기 전에 항상 확인해야 합니다. 정확한 정보를 전달하는 책임은 당신에게 있습니다. 불확실한 경우 추가 소스를 참조하여 정보를 공유하기 전에 확인하세요.

오류 예시 분석

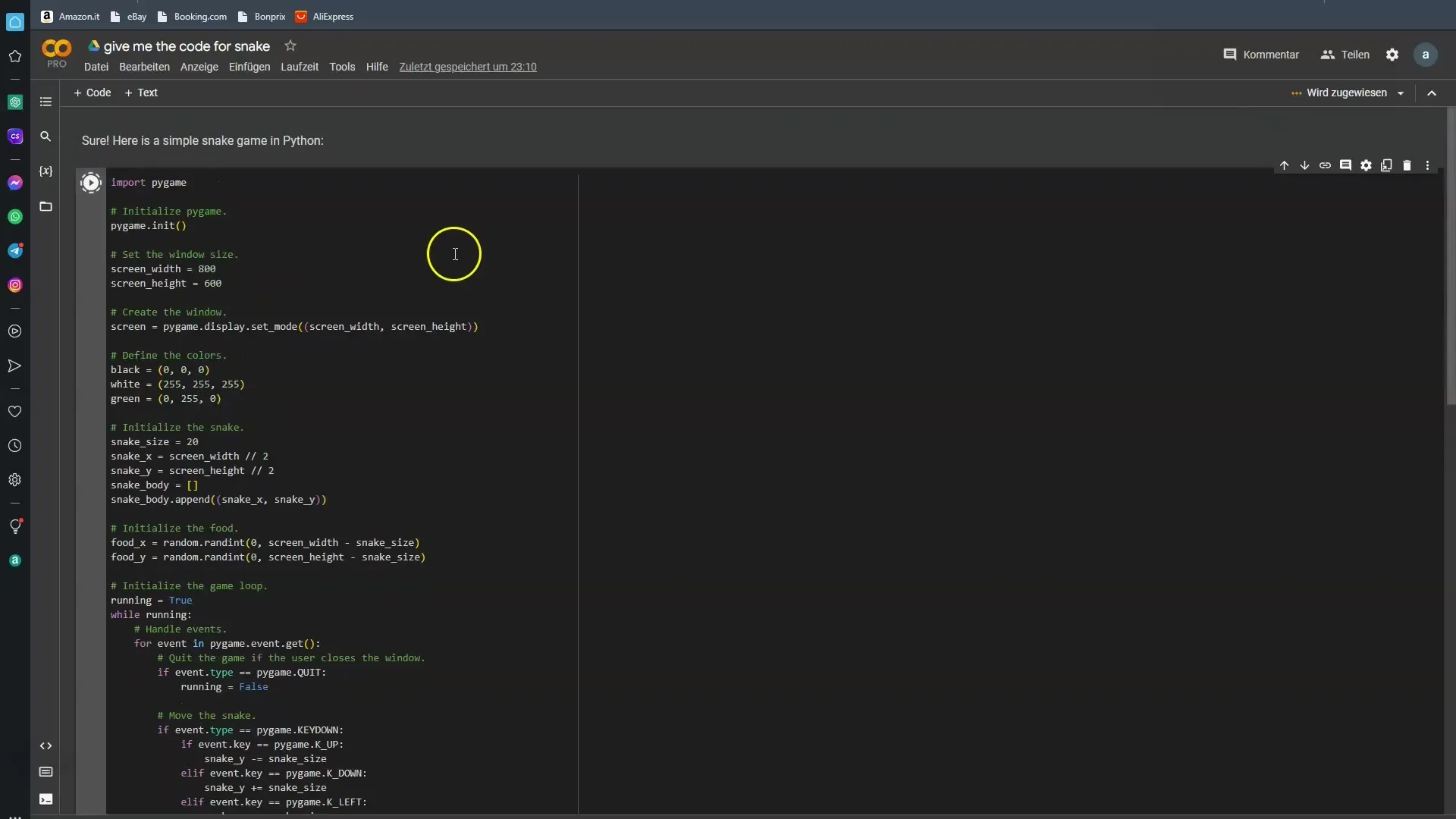

Google Bard의 오류를 이해하기 위해 구체적인 예시를 살펴보는 것이 유용합니다. 저는 프로그래밍 초보를 위한 간단한 Snake 게임의 프로그램 코드를 Bard에게 요청했습니다. 대부분의 경우 Bard는 실패했습니다. 이번에는 더 행운이 있기를 바랍니다.

정보의 실제 적용

기술적인 질문을 하고 싶을 때는 Google Bard의 답변이 항상 당신의 기대에 부응하지 않을 수 있음을 인식해야 합니다. 원하는 결과물을 받는지 확인하기 위해 다양한 조건에서 테스트하는 것은 괜찮습니다.

비판적 사고의 필요성

인공지능 결과물과 작업할 때마다 비판적 사고 모드로 전환하는 것이 중요합니다. Google Bard는 많은 데이터로부터 학습하도록 설계되었지만 해당 데이터가 항상 오류가 없는 것은 아닙니다.

미래 개선 전망

모델이 미래에 계속해서 개선될 것으로 기대됩니다. 기술이 발전함에 따라 오류 발생 가능성이 줄어들 것으로 희망합니다. 그럼에도 사용 시 현재 제한 사항들을 인지하고 고려하는 것이 중요합니다.

요약

AI 보조 및 정보 세계는 흥미로우며 무한한 기회가 있지만, 위험성도 내포하고 있습니다. Google Bard와 유사한 모델은 미래로의 한 걸음을 나아가지만 제한적인 면을 지니고 있습니다. 이러한 제한 사항을 이해하고 제공된 정보를 비판적 시각으로 바라보고 배우는 것이 중요합니다.

자주 묻는 질문

Google Bard의 주요 오류는 무엇인가요?Google Bard의 주요 오류는 제공된 정보의 부정확성에 있습니다.

Bard에서 제공된 정보를 확인해야 하는 이유는 무엇인가요?Google Bard에서 제공된 정보는 잘못되거나 항상 신뢰할 수 없을 수 있습니다.

기술적인 질문에 Google Bard를 사용할 수 있나요?네, 그러나 Google Bard의 답변을 비판적으로 검토하고 필요시 다른 출처를 참고해야 합니다.

Google Bard를 훈련시킨 사람은 누구인가요?Google Bard 및 유사 모델은 사람들이 훈련시킵니다. 이는 인간적 오류로 이어질 수 있습니다.

Google Bard가 미래에 더 나아질 것인가요?네, 미래 버전은 오류 가능성이 적을 것으로 기대됩니다.