In deze handleiding leer je hoe Grote Taalmodellen (LLM's) en Diffusiemodellen werken, met name in verband met Microsoft Copilot. Deze technologieën zijn essentieel voor het genereren van tekst en afbeeldingen die worden gebruikt in verschillende toepassingen van kunstmatige intelligentie. Om het volledige potentieel van deze tools te benutten, is het belangrijk om de fundamentele concepten te begrijpen die erachter zitten.

Belangrijkste inzichten

- Grote Taalmodellen (LLM's) genereren teksten op basis van een groot corpus van getrainde gegevens.

- Diffusiemodellen genereren afbeeldingen en leren door de verwerking van beeld-tekst-paren.

- De beperking door tokenlimieten is een centraal concept bij het werken met LLM's.

- Effectief Prompt Engineering is belangrijk om kwalitatief hoogwaardige antwoorden van LLM's te verkrijgen.

Stapsgewijze handleiding

Stap 1: Basisbegrip van Grote Taalmodellen (LLM's)

Om LLM's te begrijpen, moet je weten dat het taalmodellen zijn die zijn getraind op een enorme hoeveelheid teksten. Deze modellen zijn in staat vragen te beantwoorden door relevante informatie uit de geleerde tekst te extraheren. Onthoud dat je in deze context de computer bent die informatie vindt.

Je stelt een vraag en het model zoekt naar de juiste woorden in zijn "geheugen", dat bestaat uit de getrainde gegevens. Hierbij is het belangrijk dat je de juiste vragen stelt – een concept dat bekend staat als "Prompt Engineering".

Stap 2: Tokens en hun betekenis

Een LLM verwerkt tekst door woorden op te splitsen in "tokens", dus in kleinere eenheden die woorden vertegenwoordigen. Bijvoorbeeld komt een token gemiddeld overeen met ongeveer vier letters of drie kwart woord. Deze tokens zijn belangrijk omdat elk model een bepaald aantal tokens kan verwerken, wat bekend staat als tokenlimiet.

De tokenlimieten kunnen variëren: het standaardmodel GPT-3.5 heeft bijvoorbeeld een limiet van 4.000 tokens, terwijl het huidige model GPT-4 zelfs kan werken met maximaal 128.000 tokens. Het is belangrijk op te merken dat deze beperkingen het gesprek en het vermogen om informatie op te slaan en op te halen kunnen beïnvloeden.

Stap 3: Omgaan met tokenlimieten

Aangezien elk taalmodel een tokenlimiet heeft, is het cruciaal hiermee rekening te houden bij het werken met LLM's. Als de limiet wordt overschreden, kan het model "vergeten" waar jullie het over gehad hebben. Het is nuttig om samenvattingen te maken of grote teksten op te splitsen in opsommingen om de meest relevante informatie vast te leggen.

Stap 4: Begrip van Diffusiemodellen

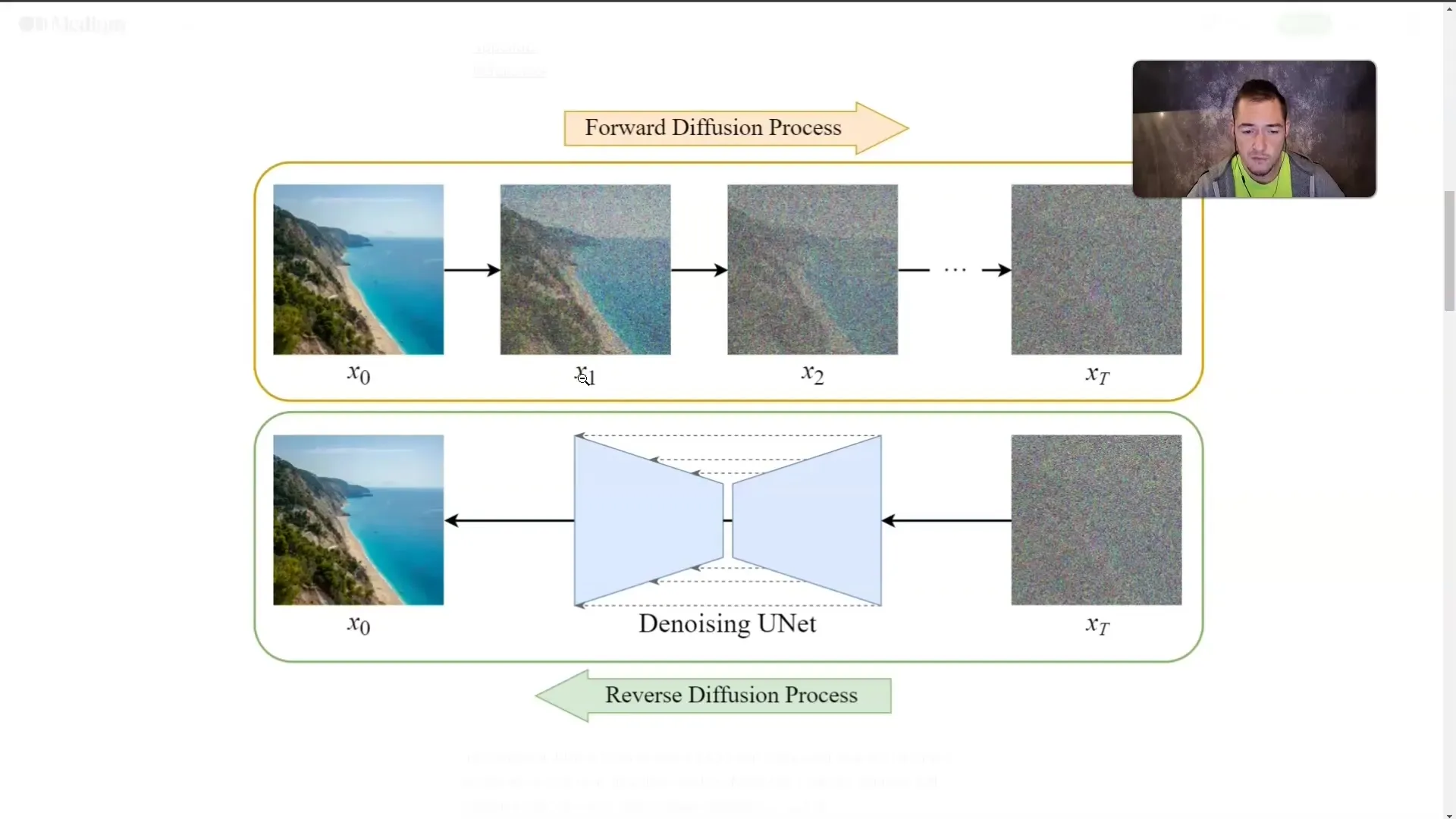

Naast de LLM's zijn ook Diffusiemodellen van groot belang. Deze modellen genereren beelden door te worden getraind met beeld-tekst-paren. Hierbij wordt een afbeelding stap voor stap met "mist" bedekt tot deze niet meer zichtbaar is. Tijdens de training leert het model hoe de afbeeldingen eruitzien, zelfs wanneer het deze niet meer direct ziet.

Deze techniek stelt het model in staat om vanuit een beschrijvende tekst een afbeelding te genereren. Hoe gedetailleerder je de gewenste inhoud beschrijft, hoe nauwkeuriger het model de afbeelding kan genereren.

Stap 5: Toepassing van de concepten

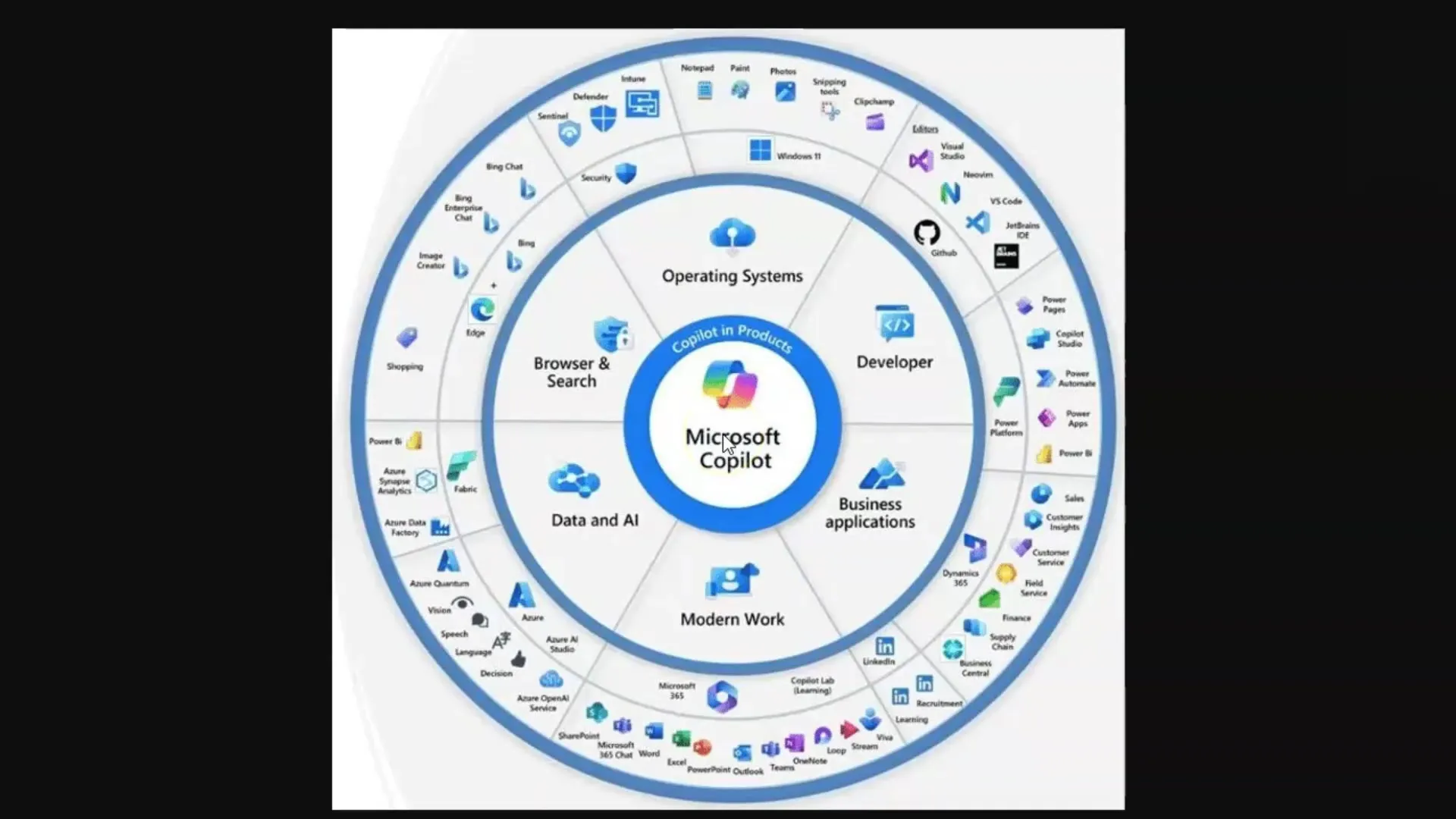

Nadat je de werking van LLM's en Diffusiemodellen hebt begrepen, is het belangrijk deze kennis praktisch toe te passen. Bij het gebruik van Microsoft Copilot moet je altijd precieze en relevante vragen stellen om de beste resultaten te behalen.

Of je nu teksten genereert of afbeeldingen ontwerpt, de kwaliteit van je invoer zal rechtstreeks van invloed zijn op de kwaliteit van de uitvoer.

Samenvatting

In deze handleiding heb je de fundamentele concepten van LLM's en Diffusiemodellen geleerd. Je weet nu hoe deze technologieën werken, welke rol tokens spelen en hoe belangrijk Prompt Engineering is voor de kwaliteit van de resultaten. Het begrip van deze concepten is cruciaal om effectief te kunnen werken met Microsoft Copilot en vergelijkbare AI-toepassingen.

Veelgestelde vragen

Wat zijn Grote Taalmodellen?LLM's zijn taalmodellen die getraind worden op grote hoeveelheden tekst om tekst te genereren en vragen te beantwoorden.

Wat zijn Diffusiemodellen?Diffusiemodellen zijn AI-modellen die afbeeldingen genereren door ze stapsgewijs te "vervagen" en te leren wat er achter de waas verborgen is.

Waarom zijn tokens belangrijk?Tokens zijn de kleinste eenheden van woorden die door LLM's verwerkt worden, en elk model heeft een limiet voor hoeveel tokens het tegelijkertijd kan verwerken.

Hoe kan ik de tokenlimiet omzeilen?Enkele methoden omvatten het maken van samenvattingen of het opsplitsen van teksten in opsommingen.

Wat is Prompt Engineering?Prompt Engineering verwijst naar de kunst van het stellen van effectieve en nauwkeurige vragen om kwalitatief hoogwaardige antwoorden van LLM's te krijgen.