Grote taalmodellen (LLM ) zoals Google Bard spelen een belangrijke rol bij het verstrekken van informatie en het ondersteunen van gebruikers op verschillende gebieden. Hoewel deze technologieën indrukwekkende resultaten opleveren, hebben ze ook hun beperkingen en uitdagingen. In deze tutorial ga je dieper in op de beperkingen van Google Bard. Het doel is om een kritisch begrip te ontwikkelen van hoe dergelijke modellen werken, zodat je de verstrekte informatie beter kunt evalueren en, indien nodig, kritisch kunt bekijken.

Belangrijkste bevindingen

- Google Bard en soortgelijke modellen zijn niet perfect en bevatten fouten.

- De uitkomsten kunnen inhoudelijk onjuist zijn, ook al lijken ze overtuigend.

- Je moet altijd kritisch zijn en informatie controleren voordat je deze verspreidt.

Stap-voor-stap handleiding

Het foutenpercentage begrijpen

Het is belangrijk om te beseffen dat Google Bard, net als veel andere grote taalmodellen, niet foutloos is. Je hebt waarschijnlijk al gemerkt dat de kwaliteit van de uitvoer varieert. Als je het gevoel hebt dat de resultaten niet bevredigend zijn, sta jezelf dan toe om kritisch te zijn.

Accepteer onjuiste uitvoer

Vaak kunnen de resultaten van Google Bard onjuist of zelfs helemaal verkeerd zijn. Misschien ben je dit al tegengekomen in je eigen ervaringen in deze cursus. Het is belangrijk dat je begrijpt dat de uitvoer van Bard niet altijd betrouwbaar is.

De verspreiding van informatie in twijfel trekken

Als je informatie hebt die afkomstig is van Google Bard, moet je die altijd verifiëren voordat je ze verspreidt. Je bent er zelf verantwoordelijk voor dat de informatie correct is. Als je het niet zeker weet, raadpleeg dan aanvullende bronnen voordat je iets deelt.

Voorbeelden van fouten analyseren

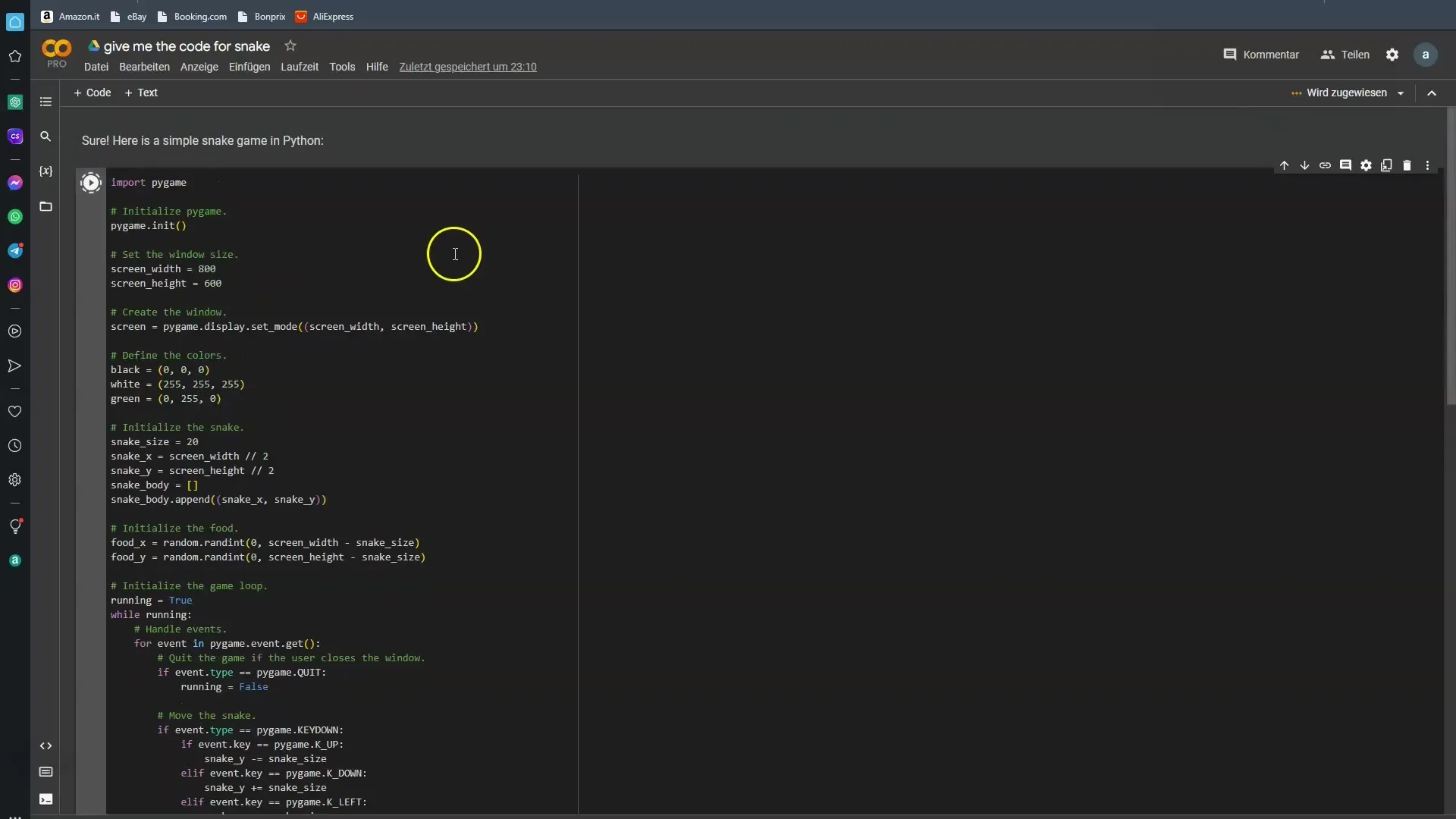

Om u te helpen visualiseren hoe gebrekkig Google Bard is, is het handig om naar specifieke voorbeelden te kijken. Ik vroeg Bard om wat code voor een eenvoudig slangenspel. In de meeste gevallen faalde Bard. Laten we eens kijken of we deze keer meer geluk hebben.

Praktische toepassing van de informatie

Vooral als je technische vragen hebt, moet je je ervan bewust zijn dat de antwoorden van Google Bard soms niet aan je verwachtingen voldoen. Het is goed om het onder verschillende omstandigheden te testen om te controleren of je de output krijgt die je wilt.

De noodzaak van kritisch denken

Wanneer je met de resultaten van de AI werkt, is het noodzakelijk om kritisch na te denken. Google Bard kan je veel voorschotelen, maar niet alles is correct. Het model is getraind om te leren van veel gegevens, maar deze gegevens zijn niet altijd foutloos.

Toekomstige verbeteringen in het verschiet

Het is te verwachten dat de modellen in de toekomst verder zullen worden verbeterd. De foutgevoeligheid zal hopelijk afnemen naarmate de technologie voortschrijdt. Toch willen we ook de huidige beperkingen erkennen, zodat u daar rekening mee kunt houden als u ze gebruikt.

Samenvatting

De wereld van AI-ondersteunde hulp en informatie is opwindend en vol mogelijkheden, maar brengt ook risico's met zich mee. Google Bard en soortgelijke modellen zijn een stap in de toekomst, maar ze hebben hun beperkingen. Het is cruciaal dat je deze beperkingen herkent en de informatie met een kritisch perspectief leert bekijken.

Veelgestelde vragen

Wat zijn de belangrijkste tekortkomingen van Google Bard? De belangrijkste tekortkomingen van Google Bard zijn de onnauwkeurigheid van de verstrekte informatie.

Waarom moet ik de informatie van Bard controleren? De informatie van Bard kan onnauwkeurig zijn en is niet altijd betrouwbaar.

Kan ik Google Bard gebruiken voor technische vragen?Ja, maar je moet de antwoorden nauwkeurig bekijken en indien nodig andere bronnen raadplegen.

Wie heeft Google Bard getraind? Google Bard en soortgelijke modellen zijn getraind door mensen, wat kan leiden tot menselijke fouten.

Wordt Google Bard beter in de toekomst?Ja, toekomstige versies zullen naar verwachting minder foutgevoelig zijn.