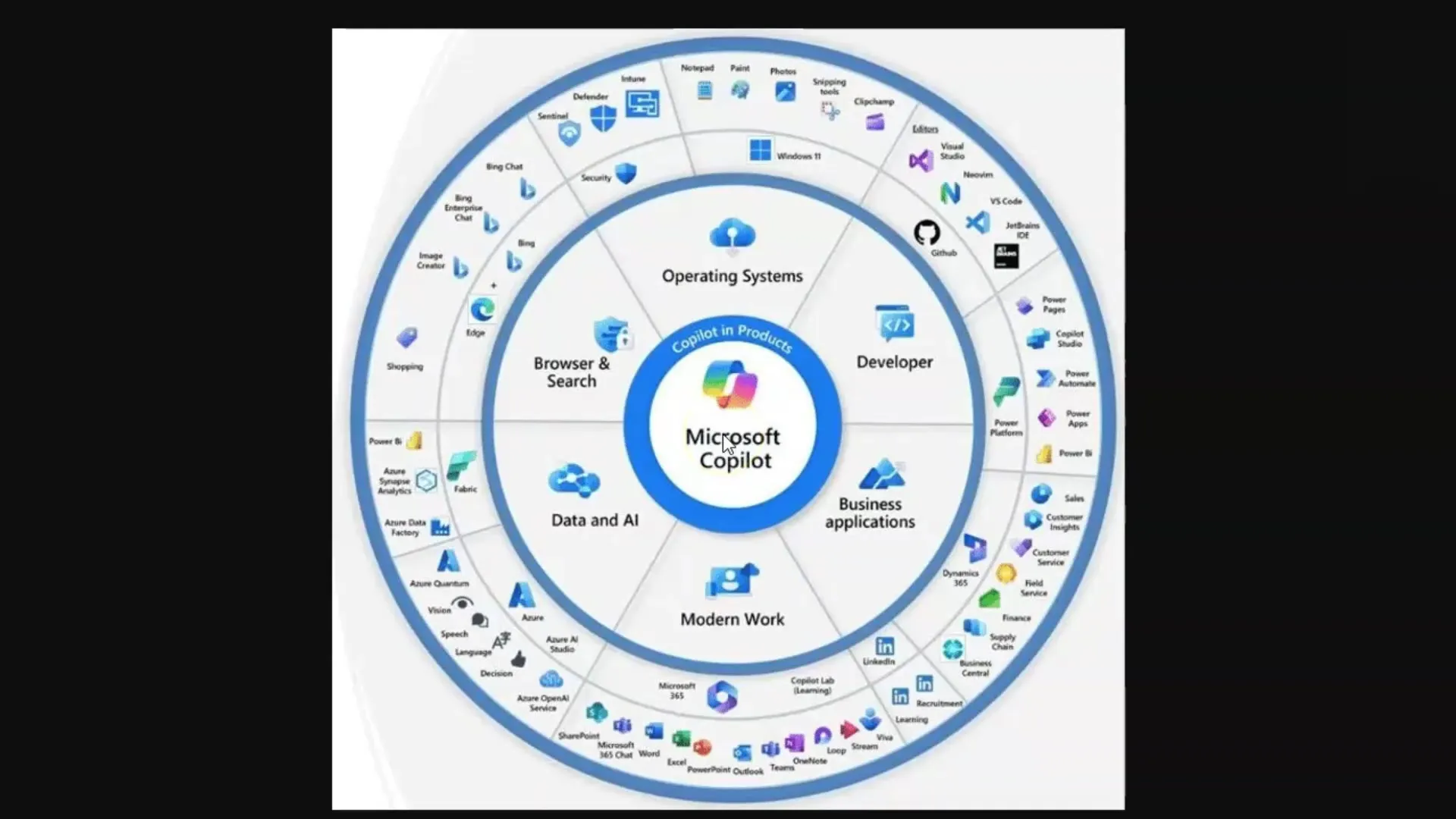

I denne opplæringen vil du lære hvordan Large Language Models (LLMs) og Diffusionmodeller fungerer, spesielt i sammenheng med Microsoft Copilot. Disse teknologiene er avgjørende for generering av tekster og bilder som brukes i ulike applikasjoner innen kunstig intelligens. For å utnytte det fulle potensialet til disse verktøyene, er det viktig å forstå de grunnleggende konseptene som ligger bak.

Viktigste innsikter

- Large Language Models (LLMs) genererer tekster basert på et stort korpus av trente data.

- Diffusionsmodeller skaper bilder og lærer ved å behandle bilde-tekst-par.

- Begrensningen av token-grenser er et sentralt begrep når man jobber med LLMs.

- Effektivt Prompt Engineering er viktig for å få kvalitetsmessige svar fra LLMs.

Trinnvis veiledning

Trinn 1: Grunnforståelse av Large Language Models (LLMs)

For å forstå LLMs må du vite at det er språkmodeller som er trent på en enorm mengde tekster. Disse modellene er i stand til å svare på spørsmål ved å trekke ut relevante opplysninger fra den lærte teksten. Husk at i denne konteksten er du datamaskinen som finner informasjonen.

Du stiller et spørsmål, og modellen søker etter de riktige ordene i "minnet" sitt, som består av de trente dataene. Her er det viktig at du stiller de riktige spørsmålene – et konsept kjent som "Prompt Engineering".

Trinn 2: Token og deres betydning

Et LLM behandler tekst ved å bryte ned ord til "tokens", det vil si mindre enheter som representerer ord. For eksempel tilsvarer et token i gjennomsnitt omtrent fire bokstaver eller tre fjerdedeler av et ord. Disse tokenene er viktige fordi hvert modell kan behandle et bestemt antall tokens samtidig, kjent som en token-grense.

Token-grensene kan variere: For eksempel har standardmodellen GPT-3.5 en grense på 4 000 tokens, mens den nåværende modellen GPT-4 kan arbeide med opptil 128 000 tokens. Det er viktig å merke seg at disse begrensningene kan påvirke samtalen og evnen til å lagre og hente informasjon.

Trinn 3: Håndtering av token-grenser

Siden enhver språkmodell har en token-grense, er det avgjørende å ta hensyn til dette når du arbeider med LLMs. Hvis grensen overskrides, kan modellen "glemme" hva dere snakket om. Her er det nyttig å lage sammendrag eller dele store tekster opp i stikkord for å fange opp de mest relevante opplysningene.

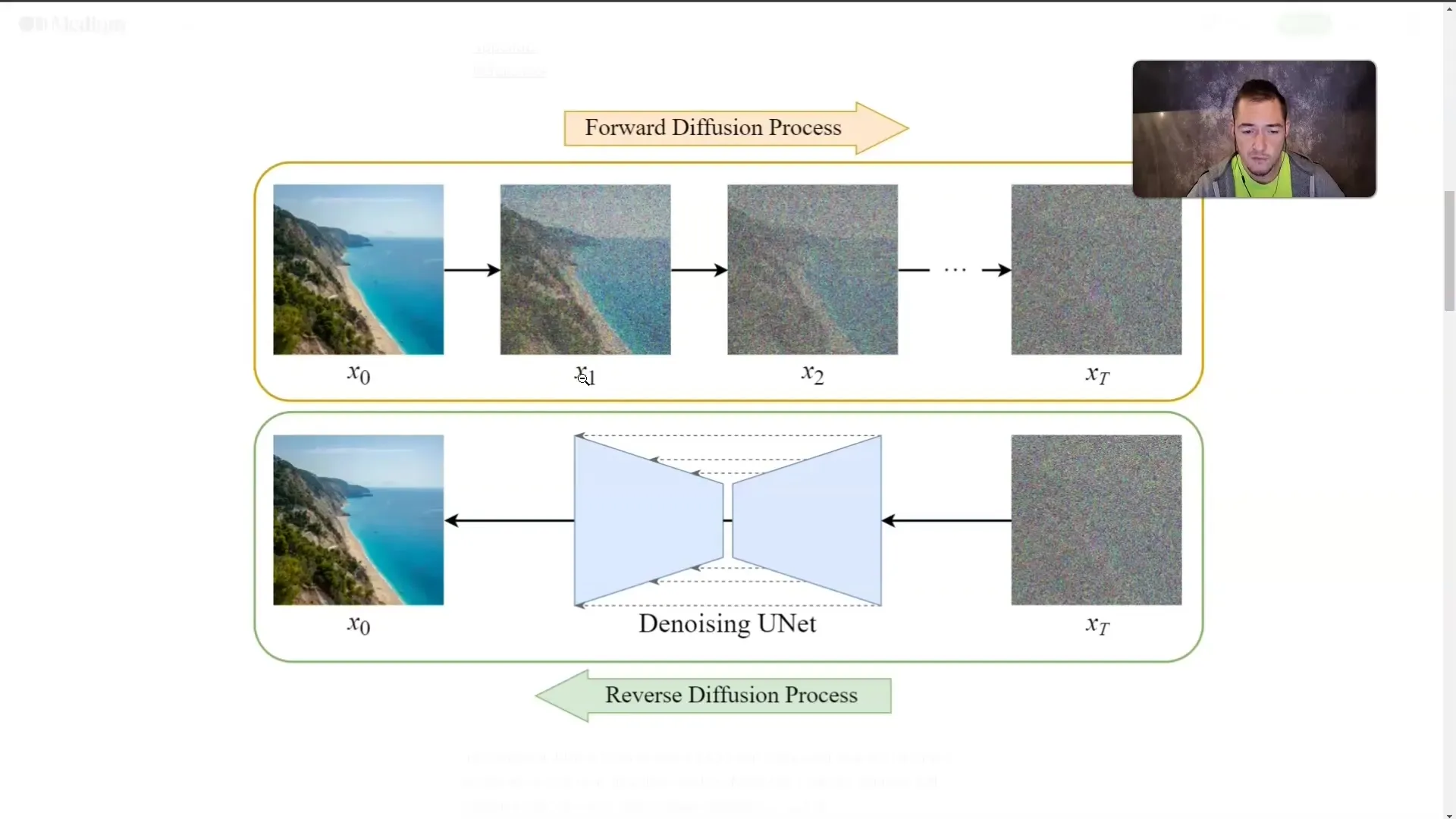

Trinn 4: Forståelse av Diffusionsmodeller

I tillegg til LLMs er Diffusionsmodeller også av stor betydning. Disse modellene genererer bilder ved å trene med bilde-tekst-par. Et bilde blir gradvis tildekket med "tåke" til det ikke lenger er synlig. I løpet av treningen lærer modellen hvordan bildene ser ut, selv om den ikke lenger direkte ser dem.

Denne teknikken lar modellen generere et bilde fra en beskrivende tekst. Jo mer detaljert du beskriver ønsket innhold, desto mer nøyaktig kan modellen lage bildet.

Trinn 5: Anvendelse av konseptene

Når du har forstått hvordan LLMs og Diffusionsmodeller fungerer, er det viktig å bruke denne kunnskapen i praksis. Når du bruker Microsoft Copilot, bør du alltid passe på å stille nøyaktige og relevante spørsmål for å oppnå de beste resultatene.

Uansett om du genererer tekster eller lager bilder, vil kvaliteten på inndataene direkte påvirke kvaliteten på resultatene.

Oppsummering

I denne opplæringen har du lært de grunnleggende konseptene bak LLMs og Diffusionsmodeller. Nå vet du hvordan disse teknologiene fungerer, hvilken rolle tokens spiller, og hvor viktig Prompt Engineering er for kvaliteten på resultatene. Forståelsen av disse konseptene er avgjørende for å effektivt jobbe med Microsoft Copilot og lignende AI-applikasjoner.

Ofte stilte spørsmål

Hva er Large Language Models?LLMs er språkmodeller som er trent på store mengder tekst for å generere tekster og svare på spørsmål.

Hva er Diffusionsmodeller?Diffusionsmodeller er AI-modeller som genererer bilder ved gradvis å "tildekke" dem og lære hva som er skjult bak tåken.

Hvorfor er tokens viktige?Tokens er de minste enhetene i ordene som LLMs behandler, og hver modell har en grense for hvor mange tokens den kan behandle samtidig.

Hvordan kan jeg omgå token-grensen?Noen metoder inkluderer å lage sammendrag eller dele tekster opp i stikkord.

Hva er Prompt Engineering?Prompt Engineering refererer til kunsten å stille effektive og nøyaktige spørsmål for å få kvalitetsmessige svar fra LLMs.