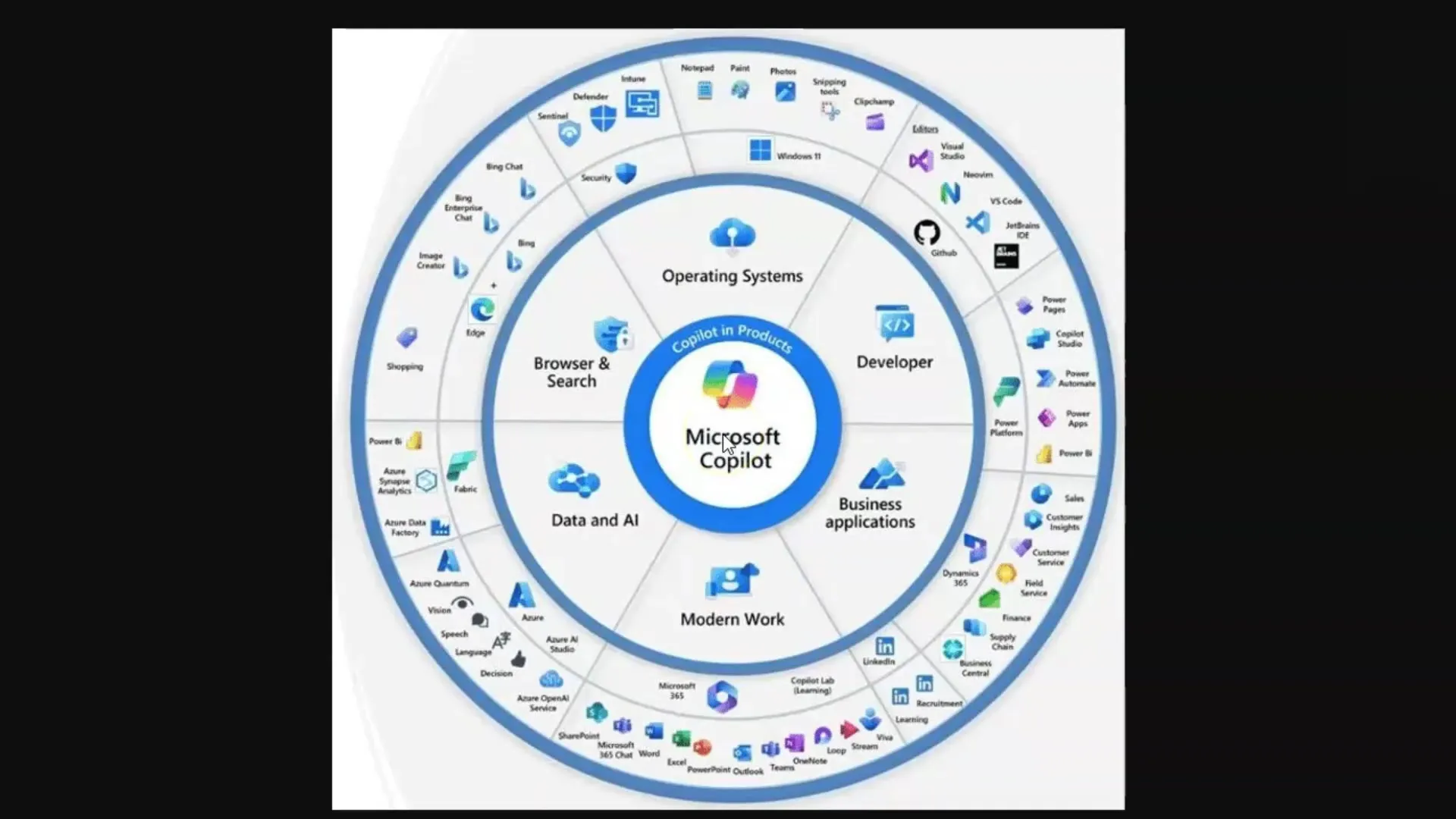

W tym samouczku nauczysz się, jak działają Duże Modele Językowe (LLM) i modele dyfuzyjne, w szczególności w kontekście Microsoft Copilot. Te technologie są kluczowe dla generowania tekstów i obrazów, które są używane w różnych aplikacjach sztucznej inteligencji. Aby w pełni wykorzystać potencjał tych narzędzi, ważne jest zrozumienie podstawowych koncepcji, na których są one oparte.

Najważniejsze wnioski

- Duże Modele Językowe (LLM) generują teksty bazując na dużej puli danych treningowych.

- Modele dyfuzyjne generują obrazy i uczą się poprzez przetwarzanie par obraz-tekst.

- Ograniczenie poprzez limity tokenów jest kluczowym pojęciem przy pracy z LLM.

- Skuteczne inżynieryjne tworzenie promptów jest istotne dla uzyskania wysokiej jakości odpowiedzi od LLM.

Instrukcja krok po kroku

Krok 1: Podstawowa znajomość Dużych Modeli Językowych (LLM)

Aby zrozumieć LLM, musisz wiedzieć, że są to modele językowe trenowane na ogromnej ilości tekstów. Modele te są zdolne do odpowiadania na pytania, wydobywając istotne informacje z przyswojonych danych tekstowych. Pamiętaj, że w tym kontekście jesteś komputerem, który znajduje informacje.

Stawiasz pytanie, a model szuka odpowiednich słów w swojej "pamięci", która składa się z trenowanych danych. Ważne jest tutaj, aby stawiać właściwe pytania - koncepcja ta jest znana jako "Inżynieria Promptów".

Krok 2: Tokeny i ich znaczenie

LLM przetwarza tekst poprzez rozkładanie słów na "tokeny", czyli mniejsze jednostki, które reprezentują słowa. Na przykład jeden token to średnio około czterech liter lub trzech czwartych słowa. Tokeny te są istotne, ponieważ każdy model może przetwarzać określoną liczbę tokenów, co nazywane jest limitem tokenów.

Limity tokenów mogą się różnić: Na przykład standardowy model GPT-3.5 ma limit 4 000 tokenów, podczas gdy aktualny model GPT-4 może działać nawet z 128 000 tokenami. Ważne jest zauważenie, że te ograniczenia mogą wpływać na rozmowę oraz zdolność do przechowywania i odzyskiwania informacji.

Krok 3: Radzenie sobie z Limitami Tokenów

Ponieważ każdy model językowy ma limit tokenów, ważne jest uwzględnienie tego podczas pracy z LLM. Przekroczenie limitu może spowodować, że model "zapomni" o czym rozmawialiście. Przydatne jest tworzenie podsumowań lub podział dużych tekstów na punkty, aby uchwycić najistotniejsze informacje.

Krok 4: Zrozumienie Modeli Dyfuzyjnych

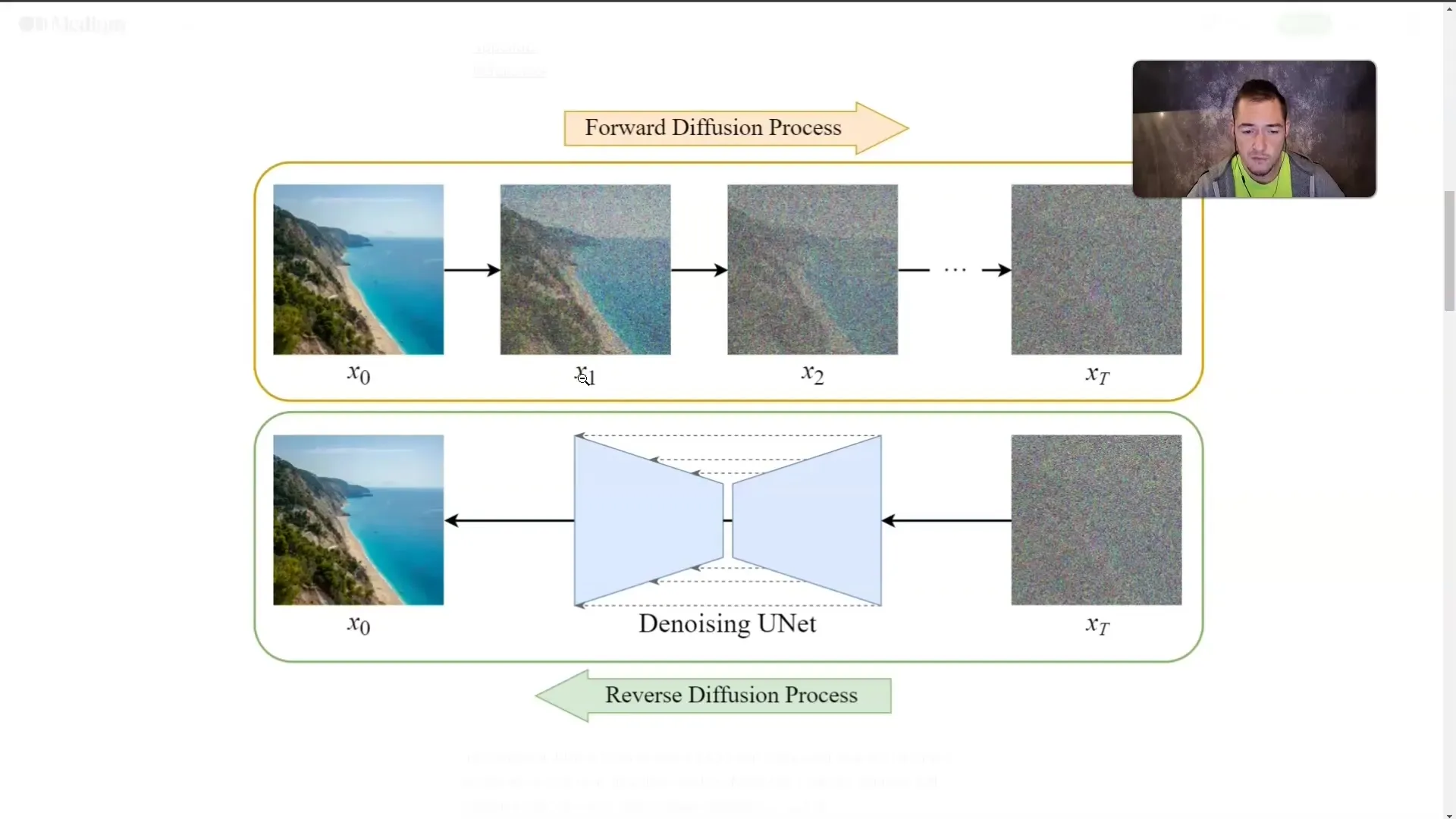

Oprócz LLM, modele dyfuzyjne są również istotne. Te modele generują obrazy, ucząc się poprzez przetwarzanie par obraz-tekst. Obraz stopniowo jest przykrywany "mgłą", aż nie będzie już widoczny. Podczas treningu model uczy się, jak wyglądają obrazy, nawet jeśli nie widzi ich bezpośrednio.

Ta technika pozwala modelowi generować obraz ze zrozumienia tekstu opisującego. Im bardziej szczegółowo opiszesz pożądane treści, tym precyzyjniej model będzie w stanie wygenerować obraz.

Krok 5: Stosowanie Koncepcji

Po zrozumieniu działania LLM i modeli dyfuzyjnych ważne jest w praktyce zastosowanie tych wiadomości. Korzystając z Microsoft Copilot, zawsze pamiętaj o zadawaniu precyzyjnych i istotnych pytań, aby osiągnąć najlepsze wyniki.

Niezależnie od tego, czy generujesz teksty czy tworzysz obrazy, jakość twoich wejść bezpośrednio wpłynie na jakość wyników.

Podsumowanie

W tym samouczku poznałeś podstawowe koncepcje LLM i modeli dyfuzyjnych. Teraz wiesz, jak działają te technologie, jaką rolę odgrywają tokeny i jak istotne jest inżynieryjne tworzenie promptów dla jakości wyników. Zrozumienie tych koncepcji jest kluczowe do efektywnej pracy z Microsoft Copilot i podobnymi aplikacjami AI.

Najczęstsze pytania

Czym są Duże Modele Językowe?LLM to modele językowe trenowane na dużych zbiorach tekstów w celu generowania tekstów i odpowiadania na pytania.

Czym są Modele Dyfuzyjne?Modele dyfuzyjne to modele AI generujące obrazy poprzez stopniowe "zamgławianie" i uczące się, co jest ukryte za mgłą.

Dlaczego tokeny są ważne?Tokeny to najmniejsze jednostki słów, które są przetwarzane przez LLM, a każdy model ma limit, ile tokenów może przetworzyć jednocześnie.

Jak mogę ominąć limit tokenów?Niektóre metody obejmują tworzenie podsumowań lub podział tekstów na punkty.

Czym jest Inżynieria Promptów?Inżynieria Promptów odnosi się do sztuki zadawania efektywnych i precyzyjnych pytań, aby otrzymać wysokiej jakości odpowiedzi od LLM.