Sztuczna inteligencja, szczególnie przy użyciu Large Language Models (LLM), takich jak Microsoft Copilot, jest istotne w zrozumieniu Inżynierii Promptów. Dobre zrozumienie polecenia wysyłanego do modelu może stanowić różnicę między pomocnym a nieprzydatnym wynikiem. W niniejszym przewodniku chcę przybliżyć Ci kilka istotnych technik Inżynierii Promptów, zwłaszcza semantyczną asocjację, strukturalne Polecenia i Role. Te koncepcje pomogą Ci formułować skuteczne polecenia, które zwiększą wydajność Microsoft Copilot. Zróbmy to!

Najważniejsze wnioski

- Inżynieria Promptów to klucz do uzyskania skutecznych wyników z Microsoft Copilot.

- Asocjacja semantyczna pozwala modelowi lepiej zrozumieć kontekstowe powiązania.

- Strukturalne Polecenia pomagają jasno komunikować konkretnie wymagania.

- Role-Prompting daje modelowi konkretne instrukcje do zdefiniowania kontekstu i dostarczenia lepszych wyników.

Instrukcja krok po kroku

1. Zrozumienie LLM

Zacznij od podstawowego zrozumienia dużych modeli językowych. Te modele są zdolne do rozbudowywania lub podsumowywania tekstów. Podajesz kilka słów i otrzymujesz obszerną odpowiedź, albo podajesz bardzo szczegółowe informacje, a model je kompresuje. Istotą jest, że działają one dzięki dobrym promptom.

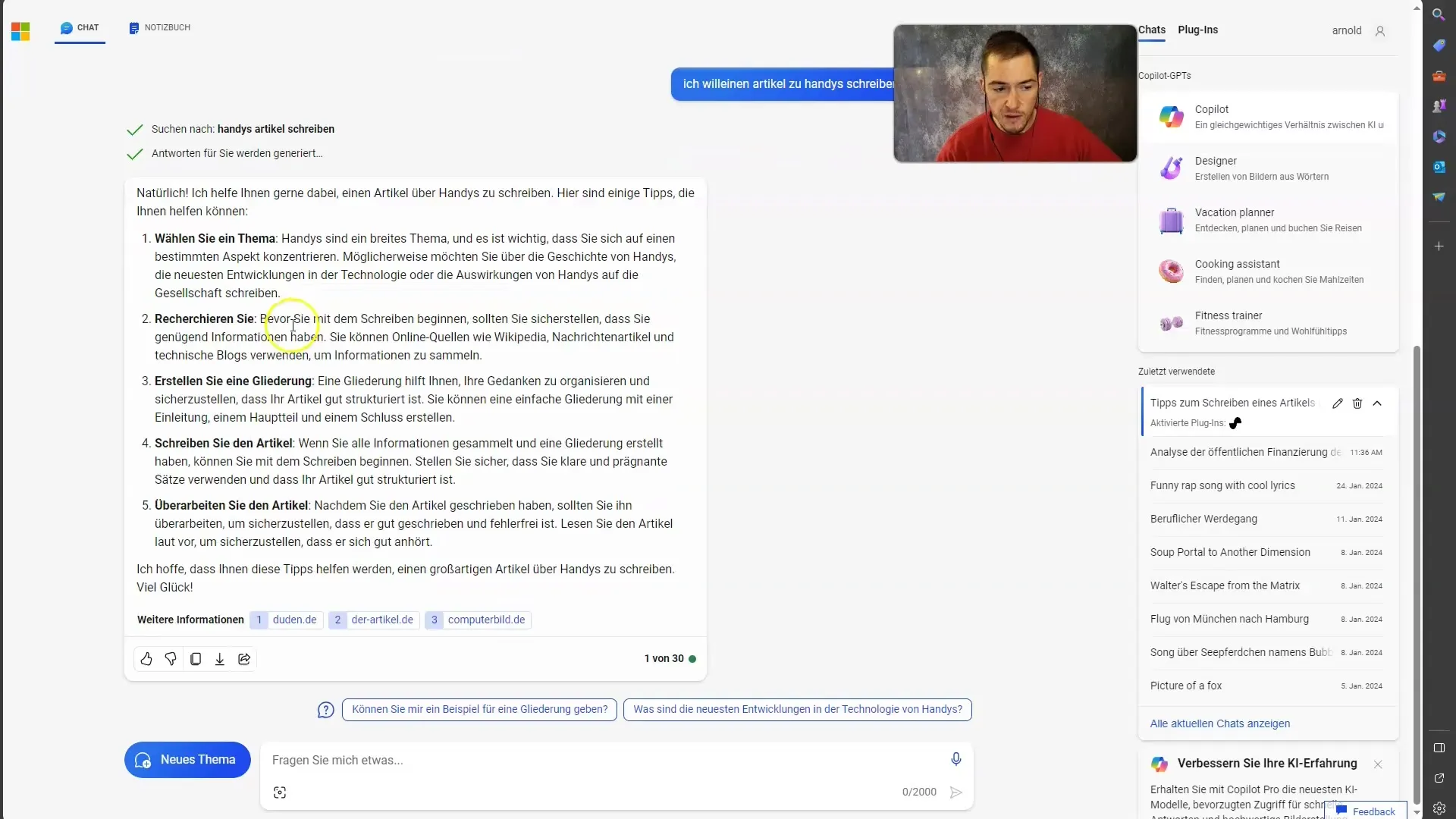

2. Przykład złego Prompta

Aby lepiej zrozumieć koncepcję, spójrzmy razem na przykład złego Promptu. Załóżmy, że chcesz napisać artykuł o telefonach komórkowych i formułujesz to w ten sposób: „Napisz artykuł o telefonach komórkowych”. Taki Prompt nie dostarcza modelowi praktycznie żadnego kontekstu, co sprawia, że odpowiedź jest z reguły niezadowalająca.

3. Rozszerzanie kontekstu

Skuteczniejszym podejściem jest podanie modelowi więcej kontekstu. Skup się na konkretnym aspekcie telefonów, np. „Google Pixel 8 Pro”. Koncentrując się na określonym temacie, zwiększasz prawdopodobieństwo, że model dostarczy wartościowych informacji.

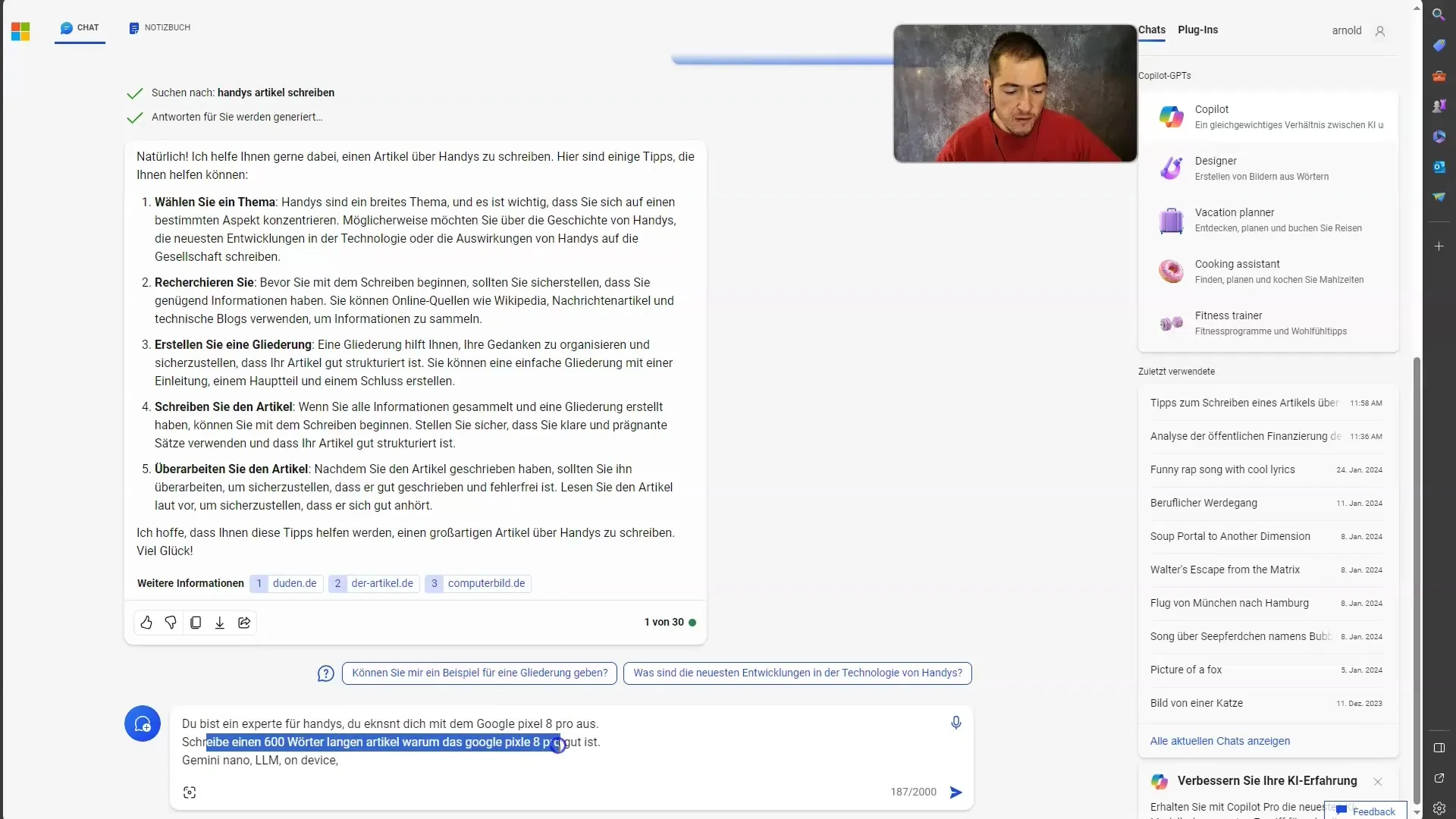

4. Użycie strukturalnych Promptów

Strukturalne Polecenia są doskonałym sposobem na jasne komunikowanie wymagań. Na przykład można powiedzieć: „Jesteś ekspertem od telefonów. Napisz artykuł na temat zalety Google Pixel 8 Pro w 600 słowach”. W Promptem jest jasne, czego oczekujesz, a model ma wystarczająco informacji do wygenerowania wyczerpującej odpowiedzi.

5. Określenie roli za pomocą Rol-Promptingu

Szczególnie przydatną techniką w Twoim Inżynieringu Promptów jest Rol-Prompting. Definiujesz rolę modelu, aby wydłużyć perspektywę. Jeśli powiesz, że model jest „ekspertem od telefonów”, wyciągnie on konkretne informacje i dostarczy Ci wynik oparty na tej wiedzy eksperckiej.

6. Integracja słów kluczowych

Aby jeszcze bardziej wzbogacić swój Prompt, możesz dodać słowa kluczowe, które będą pomocne przy generowaniu wyników. W naszym przykładzie dodanie terminów takich jak „Gemini Nano” i „on-device” może pomóc modelowi rozszerzyć kontekst i znaleźć bardziej istotne treści.

7. Zapewnienie specyficznej grupy docelowej

Pamiętaj także o tym, dla kogo przeznaczony jest artykuł. Czy dla entuzjastów technologii, ogólnych czy dla konkretnej grupy odbiorców? Model może dostosować swoją odpowiedź odpowiednio i zmienić styl pisania. To również można uwzględnić w Twoim promptu, aby model wiedział, w jaki sposób sformułować informacje.

8. Opinie i doskonalenie

Po sformułowaniu Twojego Promptu i wygenerowaniu artykułu przez model, sprawdź wynik. Czy jest to to, czego oczekiwałeś? Jeśli nie, popraw swój Prompt, dodaj więcej kontekstu lub specyficzne wymagania i spróbuj ponownie. Proces Inżynierii Promptów jest iteracyjny i czasami wymaga kilku prób.

Podsumowanie

W tym przewodniku nauczyłeś się, jak istotne jest Inżynieria Promptów dla skutecznego korzystania z Microsoft Copilot. Poprzez zrozumienie semantycznej asocjacji, strukturalnych promptów i Rollen-Promptingu możesz znacznie zwiększyć efektywność swoich wprowadzanych danych. Upewnij się, że nadajesz swojemu modelowi odpowiedni kontekst, aby osiągnąć wysokiej jakości wyniki. Eksperymentuj i udoskonalaj swoje prompty, aby uzyskać najlepsze wyniki dla swoich potrzeb!

Często zadawane pytania

Jakie są podstawowe funkcje dużych modeli językowych?Duże modele językowe mogą rozbudowywać oraz streszczać teksty.

Dlaczego kontekst w promptach jest ważny?Jasny kontekst prowadzi do wysokiej jakości i bardziej trafnych wyników.

Czym jest semantyczna asocjacja w Inżynierii Promptów?Asocjacja semantyczna pozwala modelowi rozumieć związki asocjacyjne i dostarczać bardziej trafne treści.

W jaki sposób efektywnie wykorzystać strukturalne prompty?Poprzez jasne sformułowanie konkretnych wymagań i pożądanego wyniku.

Czym jest Rollen-Prompting?Rollen-Prompting określa rolę dla modelu w celu wyjaśnienia kontekstu i umożliwienia lepszych odpowiedzi.