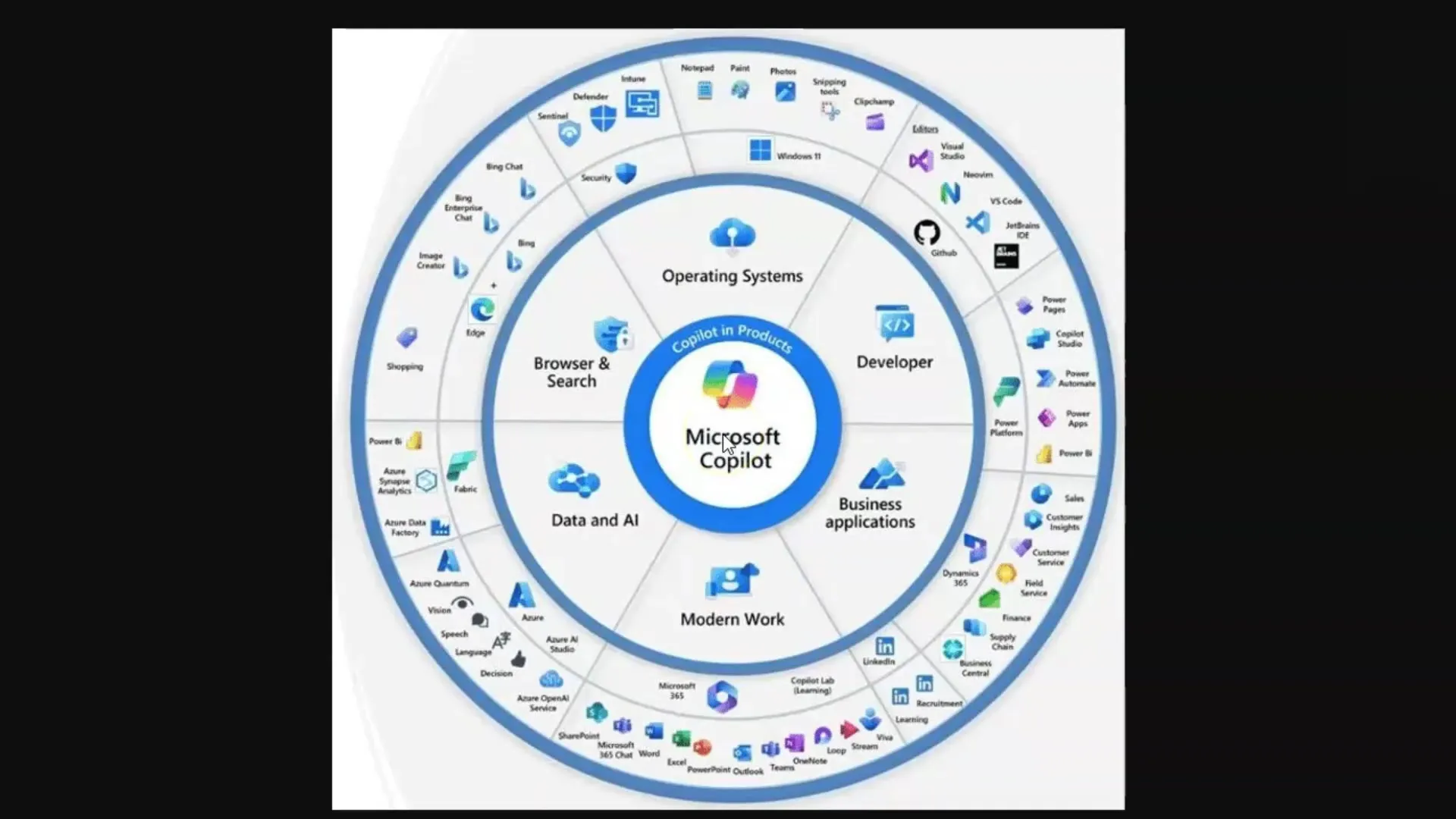

Neste tutorial, você aprenderá como os Large Language Models (LLMs) e os modelos de difusão funcionam, especialmente no contexto do Microsoft Copilot. Essas tecnologias são cruciais para a geração de textos e imagens utilizadas em várias aplicações de inteligência artificial. Para explorar todo o potencial dessas ferramentas, é importante compreender os conceitos fundamentais por trás delas.

Principais Insights

- Os Large Language Models (LLMs) geram textos com base em um grande corpus de dados treinados.

- Os modelos de difusão geram imagens e aprendem através do processamento de pares de imagem-texto.

- A limitação por tokens é um conceito central ao trabalhar com LLMs.

- O Prompt Engineering eficaz é importante para obter respostas de alta qualidade dos LLMs.

Guia Passo a Passo

Passo 1: Compreensão Básica dos Large Language Models (LLMs)

Para entender os LLMs, é necessário saber que são modelos de linguagem treinados em uma enorme quantidade de textos. Esses modelos são capazes de responder a perguntas extraindo informações relevantes dos textos aprendidos. Lembre-se de que, nesse contexto, você é o computador buscando informações.

Você faz uma pergunta e o modelo procura as palavras adequadas em sua "memória", que consiste nos dados treinados. Nesse processo, é crucial fazer as perguntas corretas - um conceito conhecido como "Prompt Engineering".

Passo 2: Tokens e seu Significado

Um LLM processa texto dividindo palavras em "tokens", ou seja, em unidades menores que representam palavras. Por exemplo, um token equivale, em média, a cerca de quatro letras ou três quartos de uma palavra. Esses tokens são importantes, já que cada modelo pode processar um número específico de tokens, o que é chamado de limite de tokens.

Os limites de tokens podem variar: o modelo padrão GPT-3.5, por exemplo, tem um limite de 4.000 tokens, enquanto o modelo atual GPT-4 trabalha até com 128.000 tokens. É importante notar que essas limitações podem influenciar a conversação e a capacidade de armazenar e recuperar informações.

Passo 3: Lidar com Limitações de Tokens

Dado que cada modelo de linguagem tem um limite de tokens, é crucial considerar isso ao trabalhar com LLMs. Quando o limite é ultrapassado, o modelo pode "esquecer" sobre o que vocês estavam conversando. Nesse sentido, é útil criar resumos ou dividir grandes textos em tópicos para capturar as informações mais relevantes.

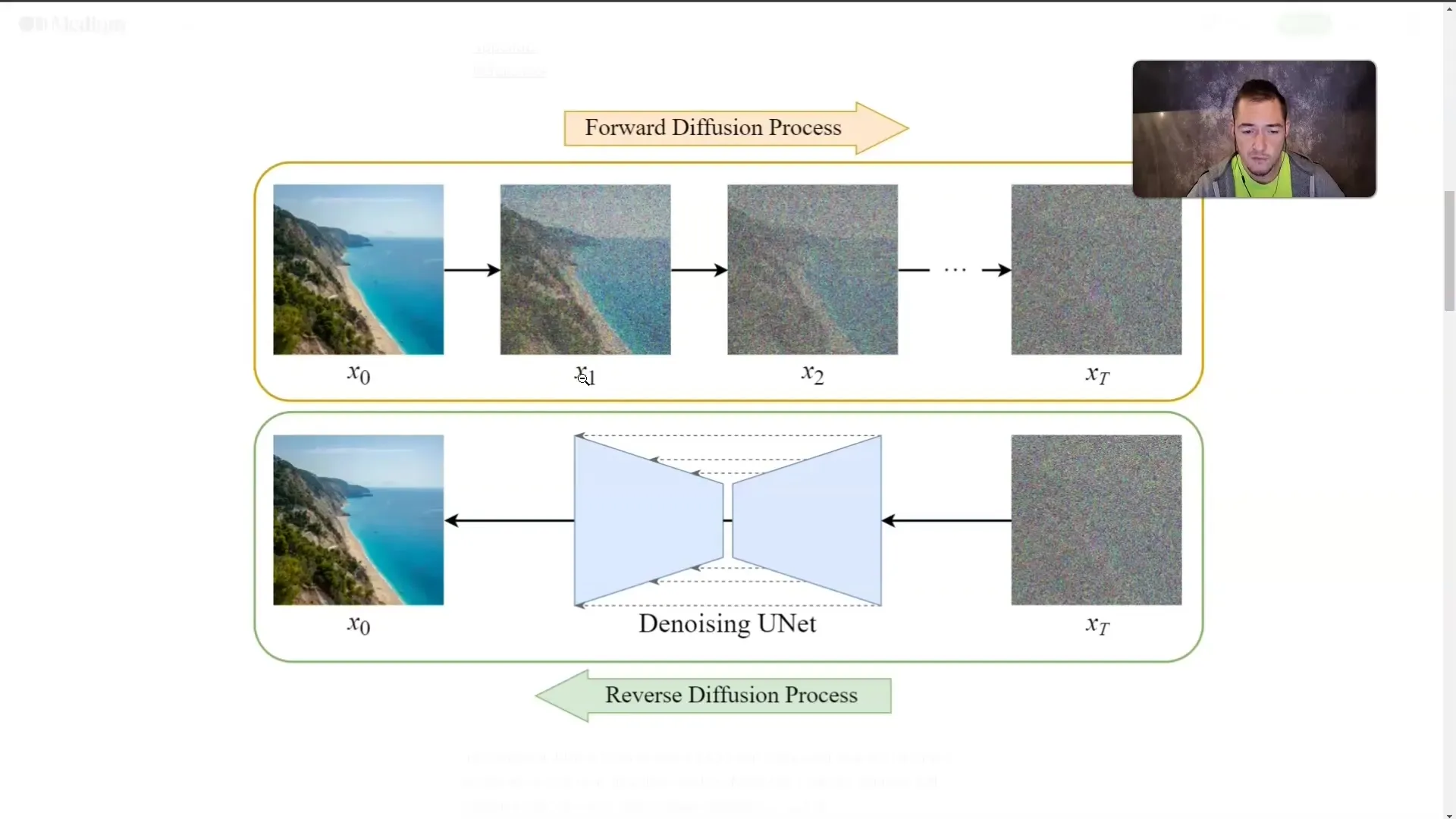

Passo 4: Compreensão dos Modelos de Difusão

Além dos LLMs, os modelos de difusão também são de grande importância. Esses modelos geram imagens ao serem treinados com pares de imagem-texto. Durante o treinamento, uma imagem é gradualmente obscurecida por "névoa" até não ser mais visível. O modelo aprende como as imagens se parecem, mesmo que não as veja diretamente.

Essa técnica permite que o modelo gere uma imagem a partir de um texto descritivo. Quanto mais detalhado for o conteúdo desejado, mais preciso o modelo poderá gerar a imagem.

Passo 5: Aplicação dos Conceitos

Depois de entender como os LLMs e os modelos de difusão funcionam, é importante aplicar esses conhecimentos na prática. Ao utilizar o Microsoft Copilot, é essencial fazer perguntas precisas e relevantes para obter os melhores resultados.

Seja ao gerar textos ou criar imagens, a qualidade de suas entradas influenciará diretamente a qualidade das saídas.

Resumo

Neste tutorial, você aprendeu os conceitos fundamentais dos LLMs e modelos de difusão. Agora você sabe como essas tecnologias funcionam, qual é o papel dos tokens e a importância do Prompt Engineering para a qualidade dos resultados. Compreender esses conceitos é essencial para trabalhar eficazmente com o Microsoft Copilot e aplicações de IA semelhantes.

Perguntas Frequentes

O que são Large Language Models?LLMs são modelos de linguagem treinados em grandes quantidades de texto para gerar textos e responder perguntas.

O que são modelos de difusão?Modelos de difusão são modelos de IA que geram imagens ao obscurecê-las gradualmente e aprendem o que está por trás das obscuridades.

Por que os Tokens são importantes?Tokens são as menores unidades das palavras processadas pelos LLMs, e cada modelo tem um limite de quantos tokens pode processar ao mesmo tempo.

Como posso contornar o limite de tokens?Algumas técnicas incluem criar resumos ou dividir textos em tópicos.

O que é Prompt Engineering?Prompt Engineering refere-se à arte de fazer perguntas eficazes e precisas para obter respostas de alta qualidade de LLMs.