Os grandes modelos linguísticos (LLM ), como o Google Bard, desempenham um papel importante no fornecimento de informações e no apoio aos utilizadores em várias áreas. Embora estas tecnologias apresentem resultados impressionantes, também têm as suas limitações e desafios. Neste tutorial, irá analisar mais detalhadamente as limitações do Google Bard. O objetivo é desenvolver uma compreensão crítica do funcionamento destes modelos, para que possa avaliar melhor e, se necessário, escrutinar as informações fornecidas.

Principais conclusões

- O Google Bard e modelos semelhantes não são perfeitos e têm erros.

- Os resultados podem estar errados em termos de conteúdo, apesar de parecerem convincentes.

- É preciso ser sempre crítico e verificar as informações antes de as divulgar.

Guia passo-a-passo

Compreender a taxa de erro

É importante compreender que o Google Bard, tal como muitos outros modelos linguísticos importantes, não está isento de erros. Já deve ter reparado que a qualidade dos resultados varia. Se achar que os resultados não são satisfatórios, permita-se ser crítico.

Aceitar resultados incorrectos

Muitas vezes, os resultados do Google Bard podem ser incorrectos ou mesmo completamente errados. É possível que já se tenha deparado com esta situação nas suas próprias experiências neste curso. É fundamental que compreenda que os resultados do Google Bard nem sempre são fiáveis.

Questionar a divulgação de informação

Se tiver informações provenientes do Google Bard, deve sempre verificá-las antes de as divulgar. O utilizador é responsável por garantir que as informações estão corretas. Se não tiver a certeza, consulte outras fontes antes de partilhar qualquer informação.

Analisar exemplos de erros

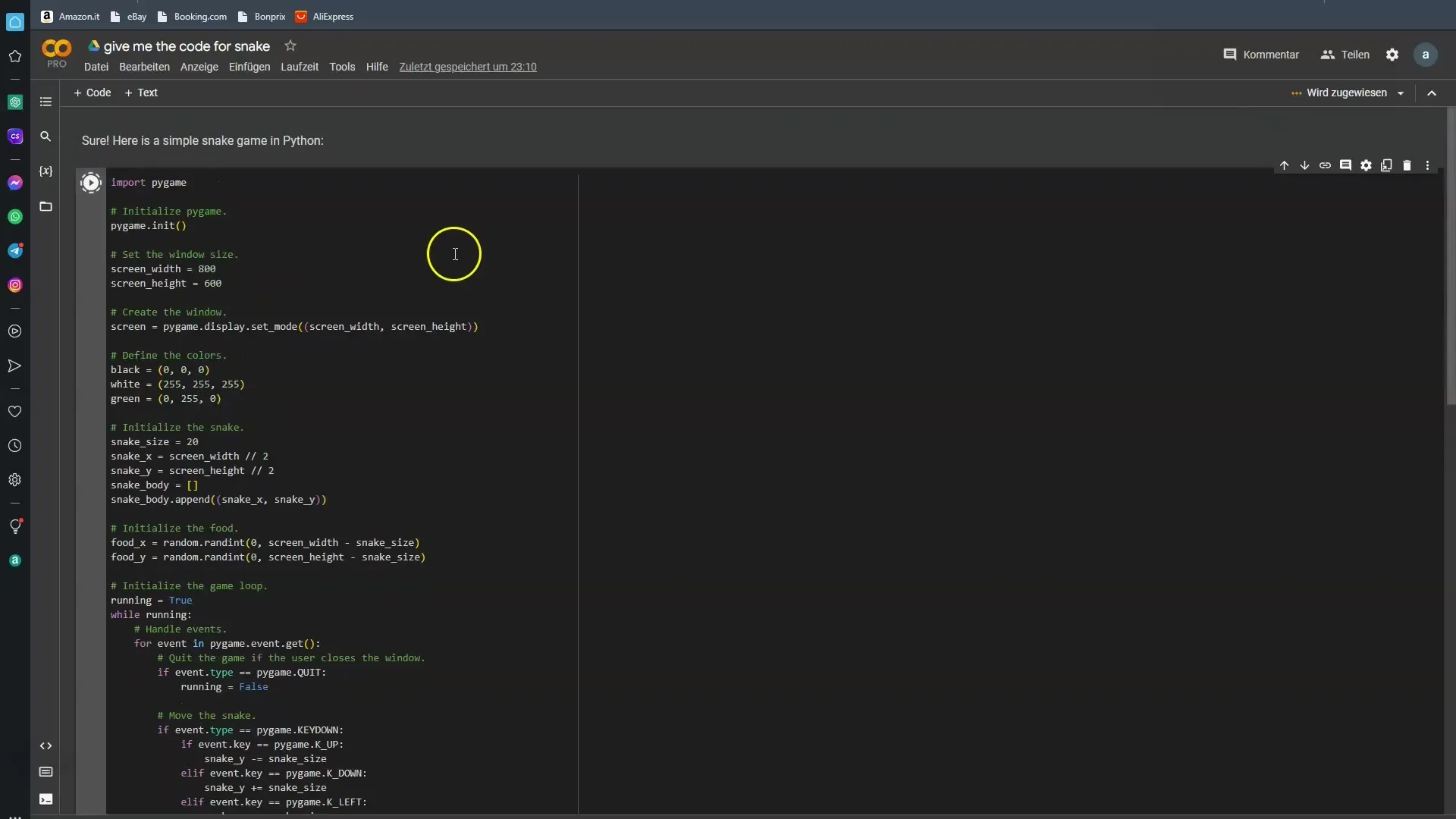

Para o ajudar a visualizar as falhas do Google Bard, é útil analisar exemplos específicos. Pedi ao Bard algum código para um simples jogo da cobra. Na maioria dos casos, o Bard falhou. Vamos ver se desta vez temos mais sorte.

Aplicação prática da informação

Especialmente se tiver questões técnicas, deve estar ciente de que as respostas do Google Bard por vezes não correspondem às suas expectativas. Não faz mal testá-lo em diferentes condições para verificar se obtém o resultado pretendido.

A necessidade de pensamento crítico

Sempre que se trabalha com os resultados da IA, é necessário passar para o modo de pensamento crítico. O Google Bard pode apresentar-lhe muita coisa, mas nem tudo está correto. O modelo é treinado para aprender com muitos dados, mas estes dados nem sempre estão isentos de erros.

Futuras melhorias no horizonte

É de esperar que os modelos venham a ser melhorados no futuro. Espera-se que a suscetibilidade a erros diminua com o avanço da tecnologia. No entanto, também queremos reconhecer as limitações actuais para que possa tê-las em conta quando as utilizar.

Resumo

O mundo da assistência e da informação apoiadas pela IA é empolgante e cheio de possibilidades, mas também encerra riscos. O Google Bard e modelos semelhantes são um passo em direção ao futuro, mas têm as suas limitações. É fundamental que reconheça estas limitações e aprenda a ver a informação com uma perspetiva crítica.

Perguntas mais frequentes

Quais são as principais falhas do Google Bard? As principais falhas do Google Bard são a imprecisão das informações fornecidas.

Por que razão devo verificar as informações fornecidas pelo Bard? As informações fornecidas pelo Bard podem ser imprecisas e nem sempre são fiáveis.

Posso utilizar o Google Bard para questões técnicas?Sim, mas deve analisar as respostas e consultar outras fontes, se necessário.

Quem treinou o Google Bard?O Google Bard e modelos semelhantes são treinados por humanos, o que pode levar a erros humanos.

O Google Bard vai melhorar no futuro?Sim, espera-se que as versões futuras sejam menos propensas a erros.