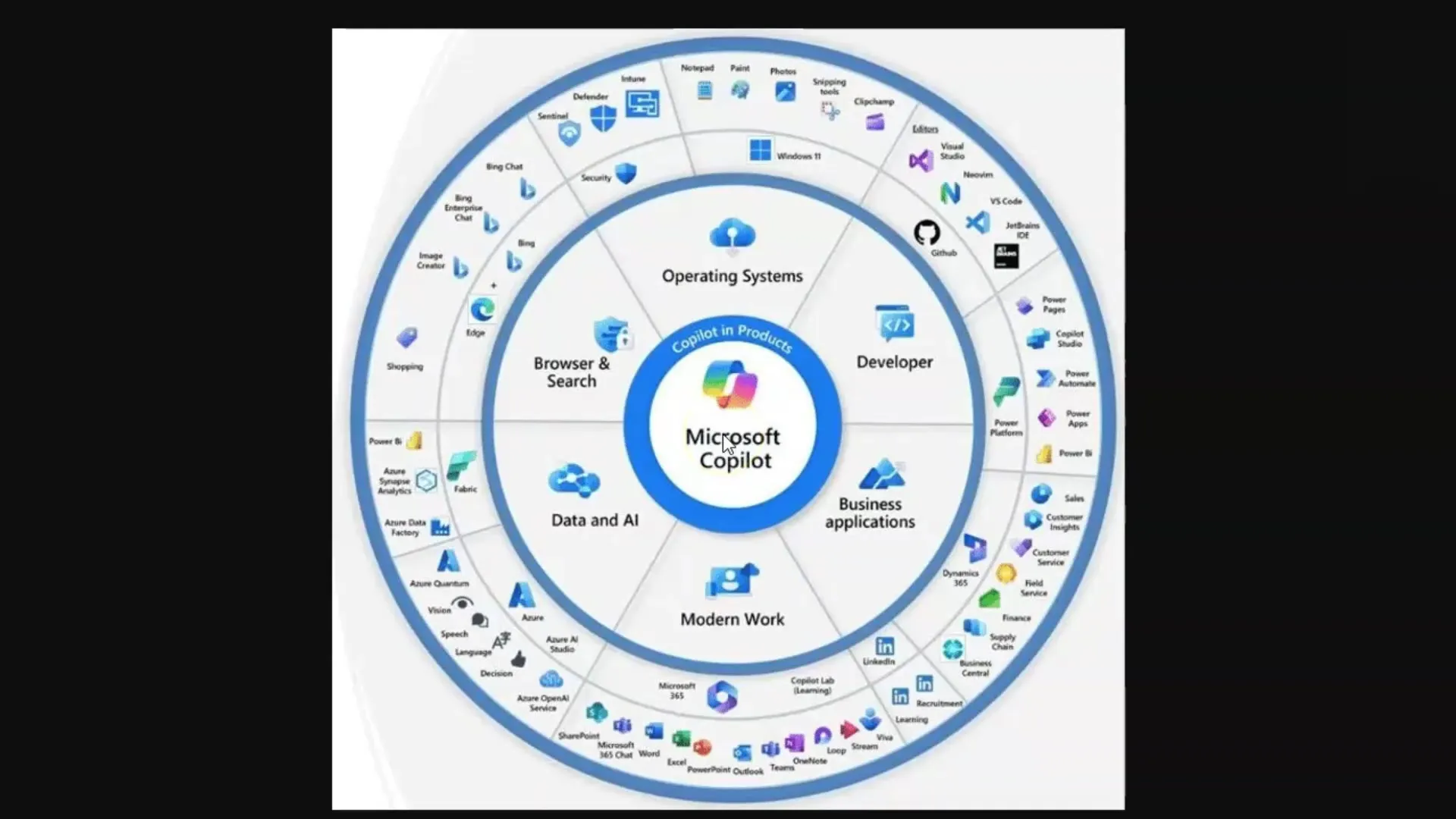

În acest tutorial vei învăța cum funcționează Large Language Models (LLMs) și modelele de Diffuzie, în special în legătură cu Microsoft Copilot. Aceste tehnologii sunt cruciale pentru generarea de texte și imagini utilizate în diverse aplicații de inteligență artificială. Pentru a valorifica pe deplin potențialul acestor instrumente, este important să înțelegi conceptele de bază care stau la baza lor.

Concluzii cheie

- Large Language Models (LLMs) generează texte pe baza unui corpus mare de date antrenate.

- Modelele de Diffuzie produc imagini și învață prin procesarea perechilor de imagine-text.

- Limitarea prin token-uri este un concept central în lucrul cu LLMs.

- Ingineria prompt-urilor eficiente este importantă pentru a obține răspunsuri de înaltă calitate de la LLMs.

Ghid pas cu pas

Pasul 1: Înțelegerea de bază a Large Language Models (LLMs)

Pentru a înțelege LLMs, trebuie să știi că acestea sunt modele de limbaj antrenate pe o cantitate imensă de texte. Aceste modele sunt capabile să răspundă la întrebări extrăgând informații relevante din textul învățat. Ține minte că în acest context ești computerul care găsește informații.

Adresezi o întrebare și modelul caută cuvintele potrivite în "memoria" sa, care constă din datele antrenate. Este important să adresezi întrebările corecte - un concept cunoscut drept "Inginerie de prompt-uri".

Pasul 2: Tokeni și înțelesul lor

Un LLM procesează textul prin descompunerea cuvintelor în "tokeni", adică în unități mai mici care reprezintă cuvintele. De exemplu, un token are în medie patru litere sau trei sferturi de cuvânt. Acești tokeni sunt importanți deoarece fiecare model poate procesa un anumit număr de tokeni, cunoscut sub numele de limită de tokeni.

Limitările de tokeni pot varia: De exemplu, modelul standard GPT-3.5 are o limită de 4.000 de tokeni, în timp ce modelul actual GPT-4 poate lucra cu până la 128.000 de tokeni. Este important să reții că aceste limitări pot influența conversația și capacitatea de a stoca și recupera informații.

Pasul 3: Gestionarea limitărilor de tokeni

Deoarece fiecare model de limbaj are o limită de tokeni, este crucial să ai acest lucru în vedere atunci când lucrezi cu LLMs. Dacă limita este depășită, modelul ar putea "uita" despre ce ați discutat. În acest sens, este util să faci rezumate sau să împarți texte mari în puncte cheie pentru a captura informațiile relevante.

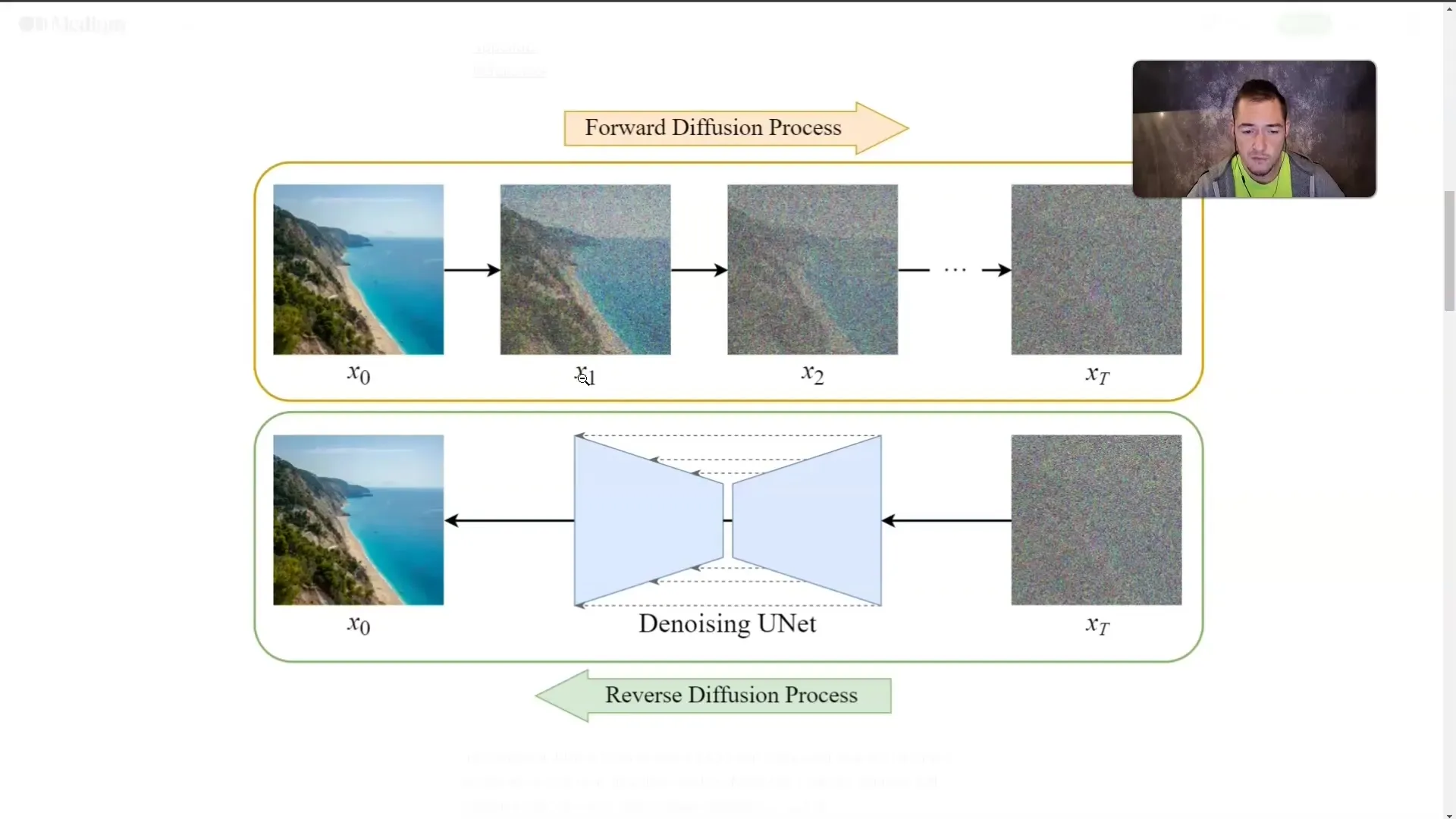

Pasul 4: Înțelegerea modelelor de diffuzie

În afara LLM-urilor, modelele de diffuzie sunt, de asemenea, extrem de importante. Aceste modele generează imagini prin antrenarea cu perechi de imagine-text. Contrastul este adăugat progresiv până când imaginea nu mai este vizibilă. În timpul antrenamentului, modelul învață cum arată imaginile, chiar dacă nu le mai vede direct.

Această tehnică permite modelului să genereze o imagine dintr-un text descriptiv. Cu cât descrii mai detaliat conținutul dorit, cu atât modelul poate genera mai precis imaginea.

Pasul 5: Aplicarea conceptelor

După ce ai înțeles modul de funcționare al LLM-urilor și modelelor de diffuzie, este important să aplici practic aceste cunoștințe. Când folosești Microsoft Copilot, fii mereu atent să adresezi întrebări precise și relevante pentru a obține cele mai bune rezultate.

Fie că generezi texte sau creezi imagini, calitatea intrărilor tale va influența direct calitatea rezultatelor.

Rezumat

În acest tutorial, ai învățat conceptele de bază ale LLM-urilor și modelelor de diffuzie. Acum știi cum funcționează aceste tehnologii, ce rol joacă tokenii și cât de important este Prompt Engineering pentru calitatea rezultatelor. Înțelegerea acestor concepte este crucială pentru a lucra eficient cu Microsoft Copilot și aplicații similare de AI.

Întrebări frecvente

Ce sunt Large Language Models?LLM-urile sunt modele de limbaj antrenate pe volume mari de texte pentru a genera texte și a răspunde la întrebări.

Ce sunt modelele de diffuzie?Modelele de diffuzie sunt modele AI care generează imagini adăugând treptat "cețuri" și învățând ce se află în spatele cețurilor.

De ce sunt importanți tokenii?Tokenii sunt cele mai mici unități ale cuvintelor procesate de LLM-uri, iar fiecare model are o limită pentru câți tokeni poate procesa simultan.

Cum pot evita limita de tokeni?Câteva metode includ crearea de rezumate sau segmentarea textelor în puncte cheie.

Ce este Prompt Engineering?Prompt Engineering se referă la arta de a formula întrebări eficiente și precise pentru a obține răspunsuri calitative de la LLM-uri.