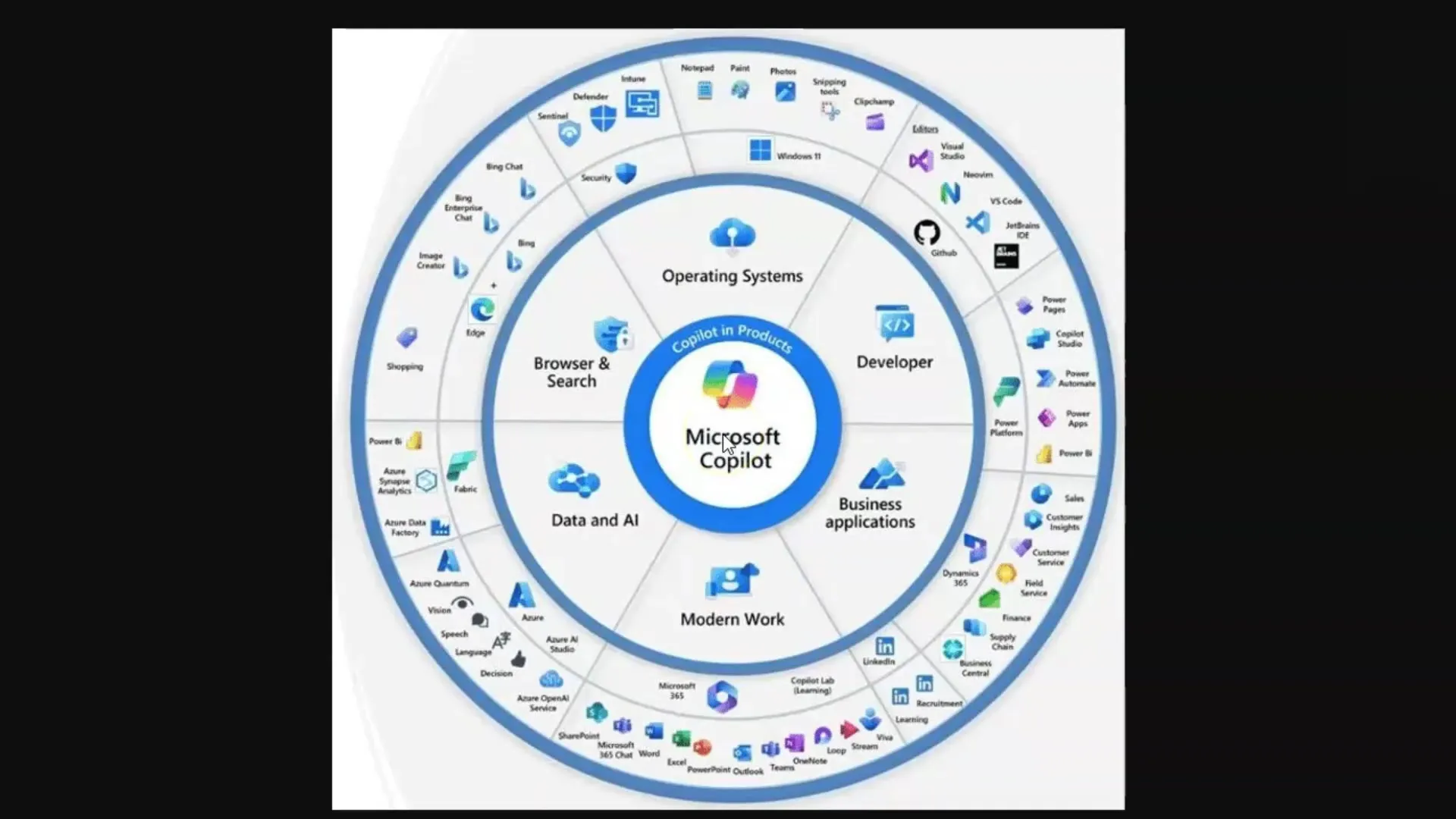

I den här handledningen kommer du att lära dig hur Stora Språkmodeller (LLMs) och Diffusionsmodeller fungerar, särskilt i samband med Microsoft Copilot. Dessa teknologier är avgörande för generering av texter och bilder som används i olika tillämpningar av konstgjord intelligens. För att kunna utnyttja dessa verktygs fulla potential är det viktigt att förstå de grundläggande begreppen som ligger till grund för dem.

Viktigaste insikter

- Stora Språkmodeller (LLMs) genererar texter baserat på en stor korpus av träningsdata.

- Diffusionsmodeller skapar bilder och lär sig genom att bearbeta bild-text-par.

- Begränsningen genom Token-limit är ett centralt begrepp när man arbetar med LLMs.

- Effektiv promptteknik är viktig för att få högkvalitativa svar från LLMs.

Steg-för-steg-guide

Steg 1: Grundförståelse av Stora Språkmodeller (LLMs)

För att förstå LLMs måste du veta att det är språkmodeller som tränas på en enorm mängd texter. Dessa modeller kan svara på frågor genom att extrahera relevant information från den inlärda texten. Kom ihåg att du i detta sammanhang är datorn som hittar information.

Du ställer en fråga och modellen letar efter de rätta orden i sitt "minne", som består av träningsdata. Det är viktigt att du ställer de rätta frågorna – ett koncept som kallas "Prompt Engineering".

Steg 2: Token och deras betydelse

En LLM bearbetar text genom att bryta ner ord i "Token", alltså i mindre enheter som representerar ord. Till exempel motsvarar ett Token i genomsnitt cirka fyra bokstäver eller tre fjärdedelar av ett ord. Dessa Token är viktiga eftersom varje modell kan hantera ett visst antal Tokens samtidigt, vilket kallas Token-limit.

Token-gränserna kan variera: Standardmodellen GPT-3.5 har till exempel en gräns på 4 000 Tokens, medan den nuvarande modellen GPT-4 till och med kan arbeta med upp till 128 000 Tokens. Det är viktigt att notera att dessa begränsningar kan påverka samtalet och förmågan att lagra och hämta information.

Steg 3: Hantera Token-begränsningar

Eftersom varje språkmodell har en Token-begränsning är det avgörande att ta hänsyn till detta när man arbetar med LLMs. Om begränsningen överskrids kan modellen "glömma" vad ni har pratat om. Det kan vara till hjälp att skapa sammanfattningar eller dela upp långa texter i punktlistor för att fånga de mest relevanta uppgifterna.

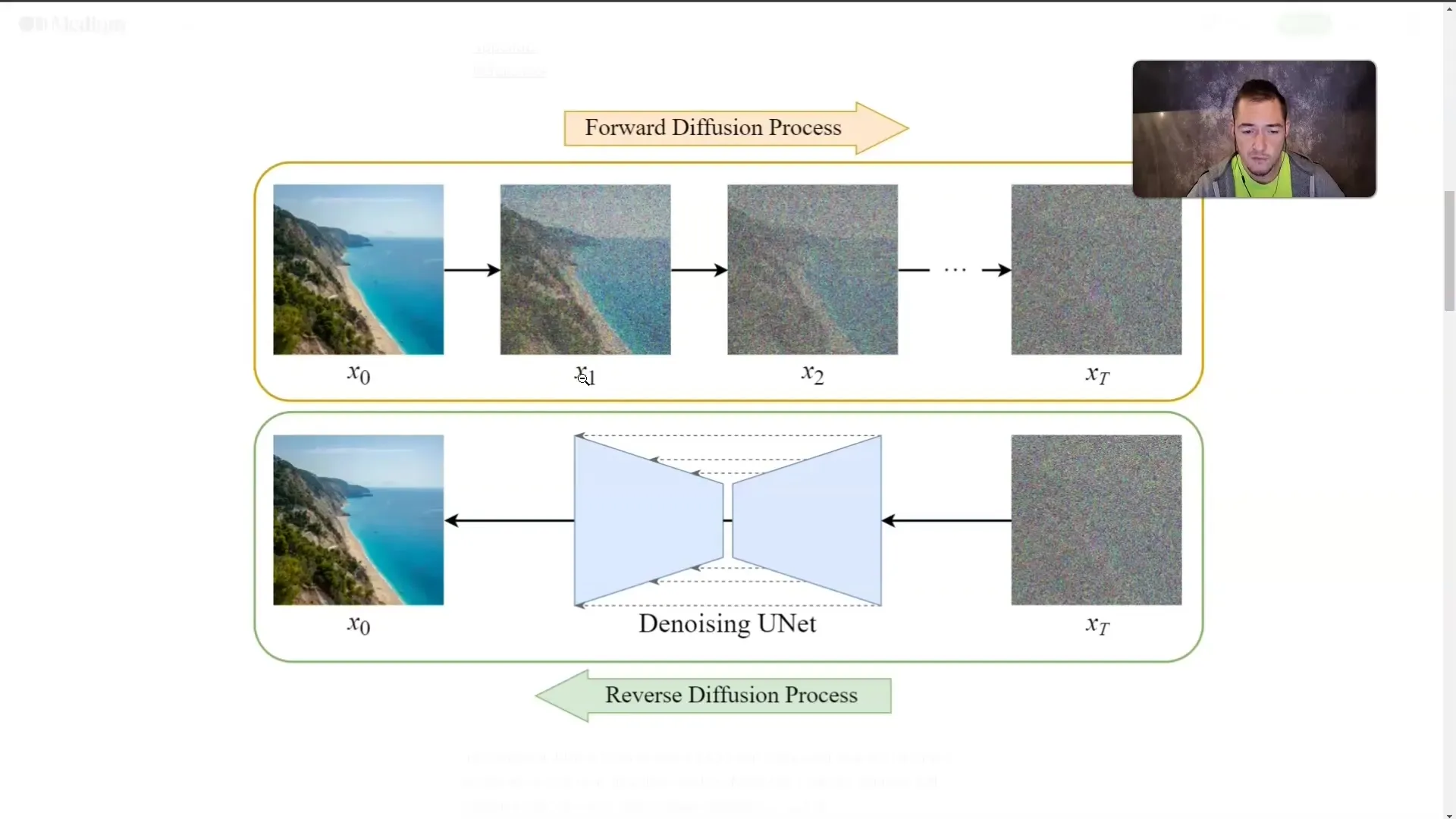

Steg 4: Förstå diffusionsmodeller

Förutom LLMs är även diffusionsmodeller av stor betydelse. Dessa modeller skapar bilder genom att träna med bild-text-par. Ett bild täcks gradvis av "dimma" tills den inte längre är synlig. Under träningen lär sig modellen hur bilderna ser ut även om den inte längre ser dem direkt.

Denna teknik gör att modellen kan generera en bild från en beskrivande text. Ju mer detaljerat du beskriver det önskade innehållet, desto mer exakt kan modellen generera bilden.

Steg 5: Tillämpning av begreppen

När du har förstått hur LLMs och diffusionsmodeller fungerar är det viktigt att tillämpa denna kunskap praktiskt. När du använder Microsoft Copilot bör du alltid se till att ställa precisa och relevanta frågor för att uppnå de bästa resultaten.

Oavsett om du genererar texter eller skapar bilder kommer kvaliteten på dina inmatningar direkt att påverka kvaliteten på resultaten.

Summering

I denna handledning har du lärt dig de grundläggande koncepten för LLMs och diffusionsmodeller. Du vet nu hur dessa teknologier fungerar, vilken roll Tokens spelar och hur viktigt Prompt Engineering är för resultatens kvalitet. Förståelsen av dessa koncept är avgörande för att effektivt arbeta med Microsoft Copilot och liknande AI-tillämpningar.

Vanliga frågor

Vad är Stora Språkmodeller?LLMs är språkmodeller som tränas på stora mängder text för att generera texter och svara på frågor.

Vad är Diffusionsmodeller?Diffusionsmodeller är AI-modeller som skapar bilder genom att gradvis ”dimma” dem och lära sig vad som döljer sig bakom dimmorna.

Varför är Tokens viktiga?Tokens är de minsta enheterna av ord som behandlas av LLMs, och varje modell har en begränsning för hur många Tokens den kan hantera samtidigt.

Hur kan jag kringgå Token-begränsningen?Några metoder innefattar att skapa summeringar eller dela upp texter i punktlistor.

Vad är Prompt Engineering?Prompt Engineering handlar om konsten att ställa effektiva och precisa frågor för att få högkvalitativa svar från LLMs.